Ai generativa, l’Italia ci prova con Vitruvian

Presentato un modello linguistico di grandi dimensioni specificamente allenato sulla lingua italiana, ancora in fase di test, ma con potenzialità interessanti L'intelligenza artificiale sta vivendo una nuova rivoluzione, mediaticamente spinta da DeepSeek ma in realtà in elaborazione da tempo. In questo scenario in rapida evoluzione, i modelli esistenti sono allenati a partire da termini in inglese poi tradotti nelle altre lingue. Questa soluzione superficialmente può andar bene, ma manca completamente il dettaglio necessario per qualsiasi argomento specialistico. Vitruvian è l'Ai madrelingua italiana L'Italia si fa ora sentire con Vitruvian_1, un modello linguistico di grandi dimensioni (LLM) sviluppato dalla italianissima Asc27, guidata da Nicola Grandis, una realtà con un solido background nel settore della cybersecurity. Ciò che distingue Vitruvian_1 dagli altri modelli anglofoni è il suo training specificamente calibrato per la lingua italiana. Vitruvian_1 è stato addestrato su dataset curati in italiano, garantendo una comprensione profonda delle sfumature linguistiche e una maggiore precisione, soprattutto in settori con terminologie complesse come medicina, diritto e strategie militari. Vitruvian_1 non solo eccelle nella comprensione della lingua italiana, ma si distingue anche per le sue capacità nel ragionamento matematico e simbolico, ottenendo risultati di rilievo in benchmark internazionali. Questo lo pone tra i modelli più avanzati nel panorama dell'Ai generativa, in grado di competere con soluzioni sviluppate da colossi come OpenAI, Anthropic e Google DeepMind. Negli ultimi giorni si è registrato il lancio di un altro modello italiano, Velvet di Almaviva, che, come Vitruvian, dichiara 14B parameters, nei modelli più diffusi questo valore arriva a circa 70. Velvet è già disponibile, mentre per Vitruvian bisognerà attendere ancora un po’. Vitruvian_1 è stato progettato per essere versatile e scalabile, con un'attenzione particolare all'efficienza energetica e alla riduzione dei costi computazionali. Grazie a tecniche di quantizzazione e pruning, il modello può essere eseguito anche su infrastrutture hardware non proprietarie, aprendo nuove possibilità in contesti non inizialmente compresi nel training. L'obiettivo di Asc27 è chiaro: consolidare Vitruvian_1 come modello di riferimento per l'Ai in Italia, offrendo un'alternativa nazionale ai giganti americani e cinesi. Un'ambizione supportata da un team di esperti e da una visione strategica orientata all'innovazione e alla valorizzazione delle competenze italiane. La fase iniziale del modello è stata completata e l’azienda ricerca betatester per andare oltre la quinta iterazione. Chi volesse candidarsi come betatester può partecipare compilando questo modulo. L'articolo Ai generativa, l’Italia ci prova con Vitruvian è un contenuto originale di Mark Up.

L'intelligenza artificiale sta vivendo una nuova rivoluzione, mediaticamente spinta da DeepSeek ma in realtà in elaborazione da tempo. In questo scenario in rapida evoluzione, i modelli esistenti sono allenati a partire da termini in inglese poi tradotti nelle altre lingue. Questa soluzione superficialmente può andar bene, ma manca completamente il dettaglio necessario per qualsiasi argomento specialistico.

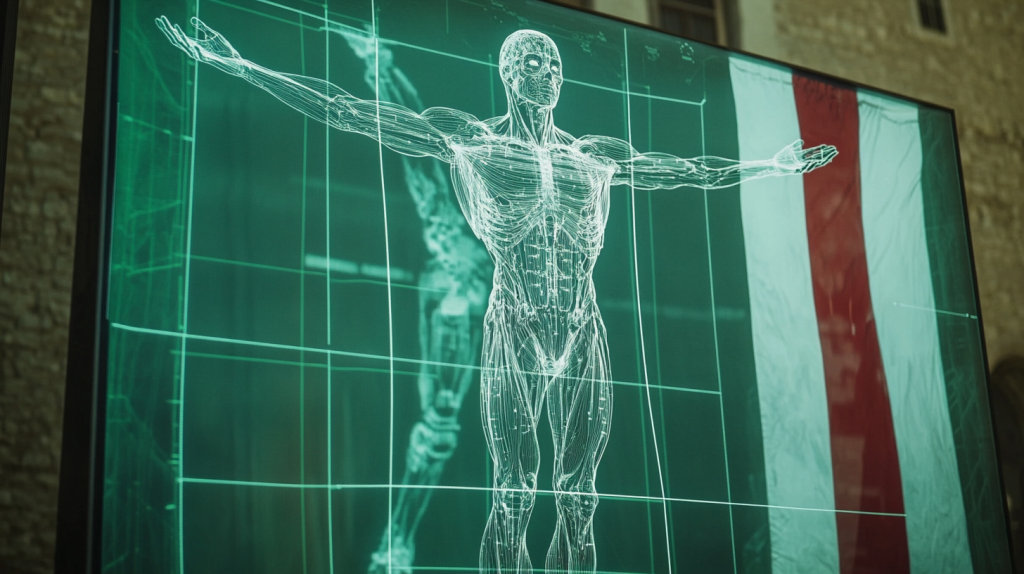

Vitruvian è l'Ai madrelingua italiana

L'Italia si fa ora sentire con Vitruvian_1, un modello linguistico di grandi dimensioni (LLM) sviluppato dalla italianissima Asc27, guidata da Nicola Grandis, una realtà con un solido background nel settore della cybersecurity. Ciò che distingue Vitruvian_1 dagli altri modelli anglofoni è il suo training specificamente calibrato per la lingua italiana. Vitruvian_1 è stato addestrato su dataset curati in italiano, garantendo una comprensione profonda delle sfumature linguistiche e una maggiore precisione, soprattutto in settori con terminologie complesse come medicina, diritto e strategie militari.

Vitruvian_1 non solo eccelle nella comprensione della lingua italiana, ma si distingue anche per le sue capacità nel ragionamento matematico e simbolico, ottenendo risultati di rilievo in benchmark internazionali. Questo lo pone tra i modelli più avanzati nel panorama dell'Ai generativa, in grado di competere con soluzioni sviluppate da colossi come OpenAI, Anthropic e Google DeepMind. Negli ultimi giorni si è registrato il lancio di un altro modello italiano, Velvet di Almaviva, che, come Vitruvian, dichiara 14B parameters, nei modelli più diffusi questo valore arriva a circa 70. Velvet è già disponibile, mentre per Vitruvian bisognerà attendere ancora un po’.

Vitruvian_1 è stato progettato per essere versatile e scalabile, con un'attenzione particolare all'efficienza energetica e alla riduzione dei costi computazionali. Grazie a tecniche di quantizzazione e pruning, il modello può essere eseguito anche su infrastrutture hardware non proprietarie, aprendo nuove possibilità in contesti non inizialmente compresi nel training. L'obiettivo di Asc27 è chiaro: consolidare Vitruvian_1 come modello di riferimento per l'Ai in Italia, offrendo un'alternativa nazionale ai giganti americani e cinesi. Un'ambizione supportata da un team di esperti e da una visione strategica orientata all'innovazione e alla valorizzazione delle competenze italiane. La fase iniziale del modello è stata completata e l’azienda ricerca betatester per andare oltre la quinta iterazione. Chi volesse candidarsi come betatester può partecipare compilando questo modulo.

L'articolo Ai generativa, l’Italia ci prova con Vitruvian è un contenuto originale di Mark Up.

/origin-imgresizer.eurosport.com/2025/02/07/4095340-83044464-310-310.png)