Gemini löst jetzt mit einem Prompt Aufgaben in verschiedenen Apps für dich

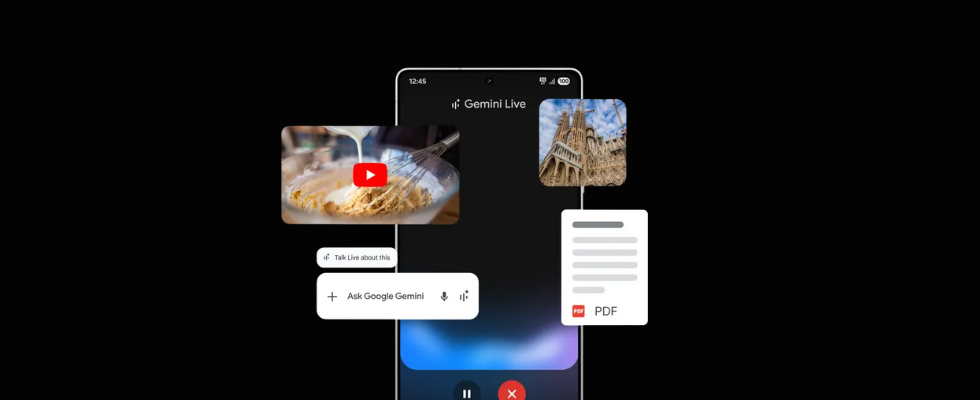

Google macht Gemini leistungsfähiger denn je: Du kannst bei Gemini Live im Gespräch Bilder, Dateien und Videos integrieren, mit nur einem Prompt verschiedene Apps bedienen und Aufgaben erledigen und die KI-Assistenz noch leichter aufrufen.

Gemini Live ist Googles Antwort auf den Advanced Voice Mode von ChatGPT. Beide Optionen kannst du inzwischen in Deutschland nutzen. Im Herbst stellte Google Gemini Live für Android User in über 40 Sprachen – darunter auch Deutsch – zur Verfügung. User der kostenfreien Gemini-Version können ebenfalls darauf zugreifen.

Jetzt gibt es noch deutlich mehr Möglichkeiten, um mit Gemini Aufgaben zu erledigen, zielführend Brainstorming zu betreiben, Kommunikation zu betreiben und Gedanken digital zu sortieren – und vieles davon können Android User mit nur einem Prompt neuerdings sogar gleichzeitig bewerkstelligen. Auf dem Samsung Galaxy Unpacked Event stellte Google die jüngsten Updates für Gemini und Gemini Live vor. Dabei steht vor allem eine Simultannutzung von Apps dank der AI-Assistenz im Fokus, mit der du Zeit sparen kannst.

Gemini 2.0:

So kannst du Googles Mega-KI-Modell testen

Bilder im Gespräch, Fragen zu Videos und Dateien: Gemini Live wird zu wissenden Gegenüber

Mit Gemini Live kannst du im Gespräch mit Googles KI deinen Ideen freien Lauf lassen, dich über Aktuelles informieren oder auch einfach nur eine Unterhaltung führen. Neuerdings können die User der Android App von Gemini aber ebenso Bilder, Videos und Dateien in diese Konversationen integrieren. Sissie Hsiao, Googles Vice President und General Manager für die Gemini App und Speech, erklärt im Blog Post, dass die Option die Chance bietet, von einem Arbeitsprozess auf dem Smartphone schnell zur Konversation mit Gemini Live zu wechseln, um Erklärungen, Hintergründe oder zusätzliche Unterstützung zu erhalten.

Because Gemini Live is built to work with Android, it’s easy to transition from what you’re doing on your phone to starting a conversation about it. And starting today, Gemini Live is becoming more versatile, allowing you to add images, files and YouTube videos to the conversation,

schreibt Hsiao. Damit können die Nutzer:innen zum Beispiel ihre Fotografieeinstellungen auf einem Bild bewerten lassen oder eine Frage zu einem für sie relevanten YouTube-Video stellen.

Diese Funktion kommt zunächst für das Samsung Galaxy S24 und die S25-Serie, sowie Google Pixel 9-Geräte. In den kommenden Wochen wird sie für weitere Geräte ausgerollt. Und in den nächsten Monaten werden Android-Geräte mit der Gemini App und das Samsung Galaxy S25 mit der Option versehen, auf Project Astra zuzugreifen. Im Rahmen von Project Astra können User über Android Phones die KI nutzen, um Konversationen in diversen Sprachen (auch gemixt) führen zu lassen, Produkte wie Lens, Maps und Search miteinzubeziehen, Konversationen zu erinnern und mit geringerer Latenz Antworten der KI zu erhalten. Wie derlei Möglichkeiten bei der Entdeckung Londons aussehen könnten, zeigt Google in einem Video.

Extensions machen App-Nutzung noch leichter – zwei Fliegen mit einer Klappe oder: Zwei Aktionen mit einem Prompt

Seit dem Frühjahr 2024 bietet Googles Gemini die Möglichkeit, via Extensions mit anderen Apps wie Google Maps, YouTube oder Google Drive verbunden zu werden und dienstübergreifend Ausgaben auszuführen. Neu ist die Option, mit einem einzigen Prompt verschiedene dieser Extensions miteinzubeziehen. Wie das funktionieren kann, erklärt Sissie Hsiao in ihrem Text:

[…] For example, if you’re looking for a list of high-protein lunch ideas, you can ask Gemini for some recipes and then easily save them to a note directly on Samsung Notes or Google Keep.

Du kannst beispielsweise auch nach einer spezifischen Location auf Google Maps suchen und die Ergebnisse mit dem gleichen Prompt an einen Kontakt schicken (lassen).

Stop endless app switching. You can now ask Gemini to complete complex tasks for you across two apps – with one prompt. Look up a location on Maps AND text it to a friend. Ask a question about a video AND save it to notes. What two-in-one tasks will you be asking Gemini? pic.twitter.com/oiDydbHO5h— Android (@Android) January 22, 2025

Diese sogenannten Multi-Extension Prompts sind für alle Gemini User im Web, auf Android und iOS verfügbar. Beschränkt auf Samsung Galaxy S25-Geräte ist indes die Option, einfach mit einem Gedrückthalten des Side Buttons die Gemini App direkt auf dem Screen aufzurufen, ohne zu dieser navigieren zu müssen.

Noch mehr Updates für Google User: Circle to search mit AI Overviews, Now Bar und Deep Research

Das Team von Google hat auf dem Samsung Galaxy Unpacked Event noch eine Reihe weiterer Features vorgestellt.

Auf Threads ansehen

Dazu gehört zum Beispiel die neue Now Bar. Diese ist für User eines Samsung Galaxy S25 verfügbar und wird im Lock Screen angezeigt. In dieser Bar können User aktuelle Sportergebnisse ihrer Lieblings-Teams oder auch Google Maps-Anweisungen auf dem gesperrten Gerät sehen.

Des Weiteren plant Google für die nächste Woche den Roll-out von Deep Research in der Gemini App. Dank dieser Funktion erhalten Advanced User zahlreiche Rechercheinformationen über die KI-Assistenz, was ihnen Zeit sparen soll; gerade in Recherchekontexten könnte das aber auch für Probleme sorgen, sofern sie ungefiltert übernommen werden.

Neben der Option, in den USA Smartphones mit Galaxy Watch7 LTE Smartwatches zu verbinden, dürfte User insbesondere ein Update für die Suchfunktion Circle to Search freuen. Denn Google integriert bei dieser AI Overviews, sodass Nutzer:innen zu den eingekreisten Bereichen KI-gestützte Suchergebnisse samt Informationen und weiterführenden Links sehen können. Darüber hinaus sorgen One-Tap Actions für bessere Bedienbarkeit bei den visuellen Suchen. Telefonnummern, Mail-Adressen oder URLs können direkt identifiziert und in Verbindung mit einem passenden CTA – wie anrufen oder die URL besuchen – eingesetzt werden.

Auf Threads ansehen

Diverse KI-Updates von Google werden inzwischen von dem hochleistungsfähigen Modell Gemini 2.0 unterstützt, das du schon testen kannst. Dieses soll das bisher beste KI-Modell Googles darstellen und bietet multimodale Optionen mit nativem Audio- und Visual Input. CEO Sundar Pichai erklärte dazu:

[…] Today we’re excited to launch our next era of models built for this new agentic era: introducing Gemini 2.0, our most capable model yet. With new advances in multimodality — like native image and audio output — and native tool use, it will enable us to build new AI agents that bring us closer to our vision of a universal assistant […].

What's Your Reaction?

:quality(80)/p7i.vogel.de/wcms/00/63/0063f797841c012fd4fd15f9934f301a/0122570112v2.jpeg?#)