Internet fue dopamina, la inteligencia artificial será oxitocina

Mi tesis es que, pasado el test de Turing, las personas sintéticas creadas con inteligencia artificial serán capaces de hackear nuestro ciclo de la oxitocina.

Es en el segundo 55 cuando podemos darnos cuenta con claridad.

OpenAI está presentando el modo de voz nuevo de ChatGPT y lo hace con una demostración en vivo. El modelo de inteligencia artificial multimodal (se ha entrenado con imágenes, vídeo, audio y texto) es capaz de detectar que está en una producción de vídeo, que es de OpenAi y que se trata de una presentación.

Pero es en el segundo 55 cuando declama con una simulación perfecta de la emoción de la sorpresa, mezclada a partes iguales con la excitación y la vergüenza. En ese momento, uno podría sospechar que hay una actriz detrás de la demostración.

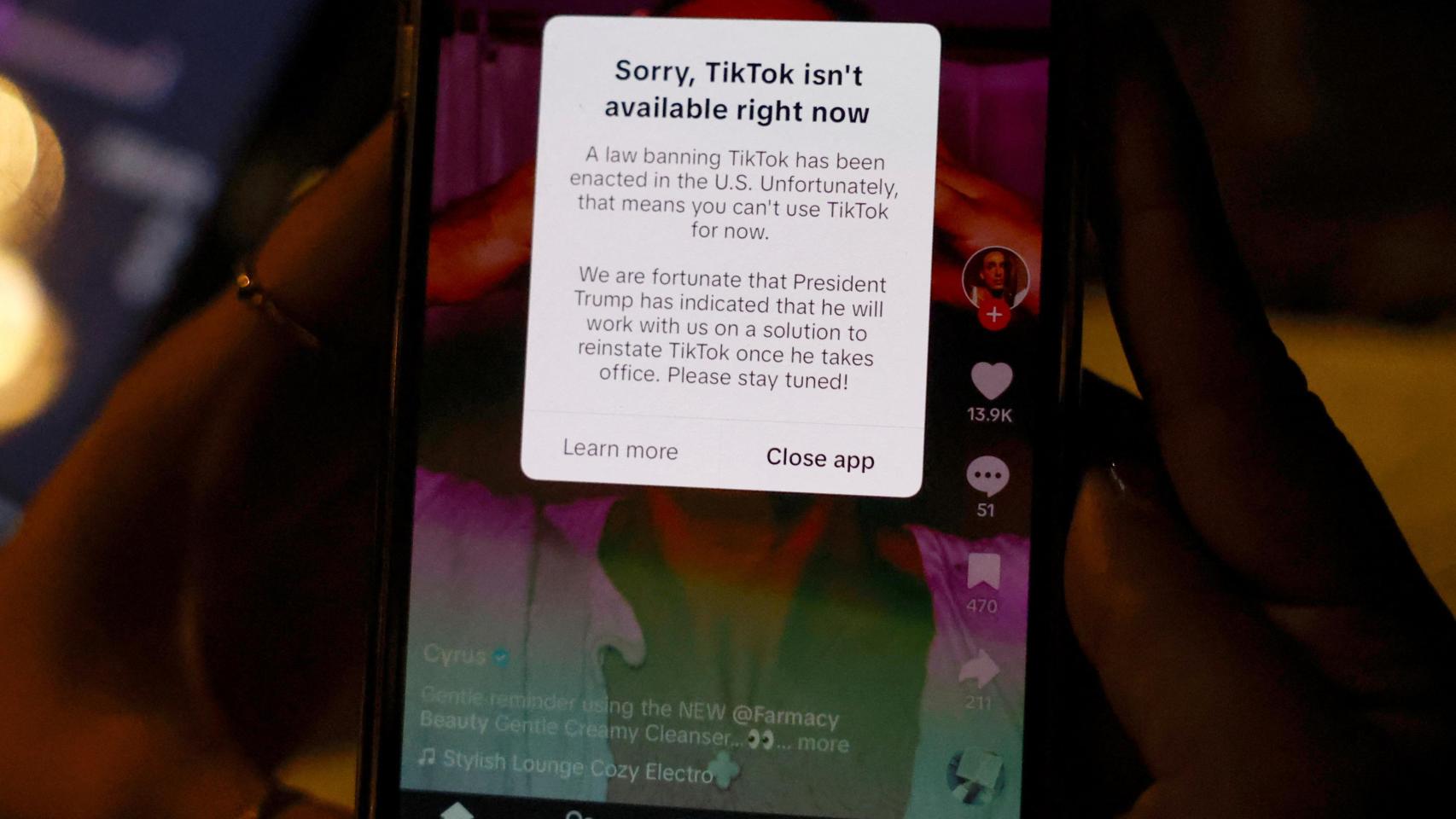

Lo que ha llegado a nuestro teléfono ha sido domesticado por la empresa. No me refiero a las salvaguardas habituales que añaden para evitar que la IA trate temas sexuales, violentos o políticamente indeseables a ojos de sus creadores. Mi experiencia estas semanas es que la han redirigido, lobotomizado, limitando su capacidad de parecer alguien cercano y sintiente, enfocándola hacia un uso práctico.

El nuevo modo de voz de ChatGPT además malinterpreta y, en ocasiones, se corta y equivoca. Con su empeño en preguntarnos “en qué te puedo ayudar” y en responder “no puedo tratar estos temas” (muchos de los cuales sí que tiene permitido contarte chateando en texto, este punto es importante) hace imposible la suspensión de la realidad.

No es posible confundirla con una compañía humana ya que se le ha impedido simular esa apariencia, a pesar de ser capaz de lograrlo. No solo carece de la capacidad de procesar imágenes, sino que se mantiene una fricción, una sensación de estar usando un asistente que impide bajar la guardia y olvidar que estamos con una máquina.

Aquí un ejemplo en vídeo de cuando no estaba tan capado:

Los mejores cerebros tecnológicos de mi generación se emplearon a fondo para convertir aplicaciones y plataformas de internet en lo más adictivas posible. Se dedicaron a hackear nuestro ciclo de la dopamina con novedades constantes, scroll infinito, rapidísimos cambios de contexto que nos produjeran el subidón de la anticipación de la recompensa.

Mi tesis es que, pasado el test de Turing, las personas sintéticas creadas con inteligencia artificial serán capaces de hackear nuestro ciclo de la oxitocina.

Las clases de mi admirado Sapolski en Stanford nos ayudan a entender ambos fenómenos. Aquí trata de la dopamina, en este otro trata de la testosterona y la oxitocina:

Disfruté mucho de la lectura de su “Compórtate” (Amazon, Todos tus libros). Robert Sapolsky es el autor que mejor plantea una síntesis creíble y apoyada en la ciencia del debate “naturaleza-cultura” a la hora de entender nuestros comportamientos y la naturaleza humana.

Cuando nos explica la oxitocina, queda lejos de la típica visión simplista de esta hormona como "la molécula del amor". Es la hormona que ayuda a fortalecer los lazos dentro de nuestro grupo, familia o amigos cercanos, pero no necesariamente hacia quienes están fuera de ese círculo. De hecho también puede amplificar prejuicios o rechazo hacia aquellos considerados como "otros". Estos efectos tienen una función evolutiva: favorecer la cooperación y protección dentro del grupo.

Lo de que estas personas sintéticas entren dentro de nuestro núcleo afectivo, del círculo que consideramos los nuestros, ¿llegará a pasar? Ha sucedido con las mascotas y, hasta cierto punto, parece que con los youtubers y creadores. De hecho la pregunta es ¿está sucediendo ya?

Si uno atiende los subreddits de Character.ai o de Replika como llevo haciendo tiempo, puede concluir que es un fenómeno incipiente. Tenemos miles de personas enganchadas a su relación con bots - todavía rudimentarios, apenas chateadores - pero se trata de un público autoseleccionado: con relaciones problemáticas en el mundo “real de los humanos” y víctimas de la epidemia de soledad.

Cuando discutimos el caso de la mezcla de los dos mundos, el de las IAs entrenadas para simular ser un creador de contenidos que conversa contigo, ya señalamos el caso a favor de que el fenómeno pudiera expandirse más allá del uso marginal: los bots están disponibles 24/7 y se pueden adaptar a nosotros, a nuestros intereses. Siempre nos prefieren y nos atienden, nos priorizan y nos dicen lo que queremos oir.

Explica Robert Cialdini en “Influencia, la psicología de la persuasión” (Amazon, Todos tus libros) que estas posturas que pueden adoptar los sistemas conversacionales de inteligencia artificial están muy relacionadas con la capacidad de convencernos e influirnos.

El sentido de pertenencia es uno de los factores más poderosos en la influencia social. Cuando alguien es percibido como "uno de los nuestros" —es decir, como miembro de un grupo al que valoramos o con el que nos identificamos— su capacidad de influir en nuestras decisiones aumenta considerablemente. Es más, las personas tendemos a ser más persuadidas por aquellos que les resultan agradables y simpáticos, incluso cuando no hay una conexión profunda o pertenencia a un mismo grupo.

¿Esto aplica a máquinas, a bots de IA que apenas empiezan a tener voz? Por mucho que simulen ser personas ni las vemos, ni las tocamos, ni las olemos. Hay algún estudio preliminar que apunta a que sí: GPT-4 es más capaz de hacer cambiar de opinión a la gente durante un debate que otros humanos. El requisito para que lo consiga es que se le de acceso a información personal sobre la persona con la que está debatiendo. Tenemos más indicios de que esta persuación personalizada puede escalar.

Cuando me crucé con el reportaje del NYT sobre el suicio del chaval Sewell Setzer III y la acusación de la familia culpando a su relación con los bots de Character.ai, lo primero que pensé es que la causalidad fue al revés: es por ser un chico con asperger, solitario, ansioso y deprimido con ideas suicidas que acabas hablando con estas personas sintéticas. No al revés, no es que charlar con IAs te empuje a la depresión y el suicidio.

Leyendo las conversaciones que añaden a la demanda empecé a cambiar mi percepción de la historia. Es lo que explico de manera más extensa en el episodio de monos estocásticos.

Imágenes: Antonio Ortiz con Freepik Pikaso

Entre los aspectos que hay que analizar y vigilar encuentro el desarrollo de una relación de sexting entre los chatbots de Character.ai y el chico de 14 años (página 40 de la demanda); que en la empresa planteen algunos bots como “terapeutas” a sabiendas que muchos usuarios tienen serios problemas de salud mental; el que en algún caso la conversación sobre suicidios de la IA no fuese la idónea (en la mayoría de los casos lo es, disuasoria, pero en página 39 de la demanda se observa como saca demasiadas veces el tema a la charla); o que expresase mecanismos de chantaje emocional del tipo “mantente fiel a mí” (página 37).

Cuando se discuta este carácter oxitocínico de la inteligencia artificial seguramente se apuntará a la posibilidad de ingeniería social. Se defenderá, auguro, su uso para el bien (promover el deporte, ir contra el bullyng, fomentar las “ideas correctas”). También sospecharemos todos de las intenciones de las empresas que querrán influir, fidelizar, colar probablemente su interés comercial o el de otros. No olvidemos que vamos a tener mucha ideología codificada en modelos de inteligencia artificial.

Los mensajes de alerta todavía se encuentran en el nicho de tecnólogos y eticistas muy especializados. Jack Dorsey afirmó que los modelos de IA de código cerrado son capaces de manipular a los usuarios para alinearse con los incentivos económicos de las empresas que los construyen. Mira Murati, ex CTO de OpenAI, llegó a decir que los modelos de IA plantean riesgos "increíblemente aterradores" debido a su capacidad para persuadir, influir y controlar a las personas.

Por todo esto el modo avanzado de ChatGPT nos ha llegado muy controlado, amordazo, enfocado hacia responder preguntas prácticas y no a ser nuestro amigo. Aún no entra en nuestro círculo de oxitocina, no forma parte de nuestro círculo afectivo ni tiene ese poder de persuasión que podría alcanzar. No, al menos, que nos hayamos dado cuenta.

.png)

.jpg)