В нейросетях devo вроде как реализовали, а для evo нужно ещё разобраться с eco

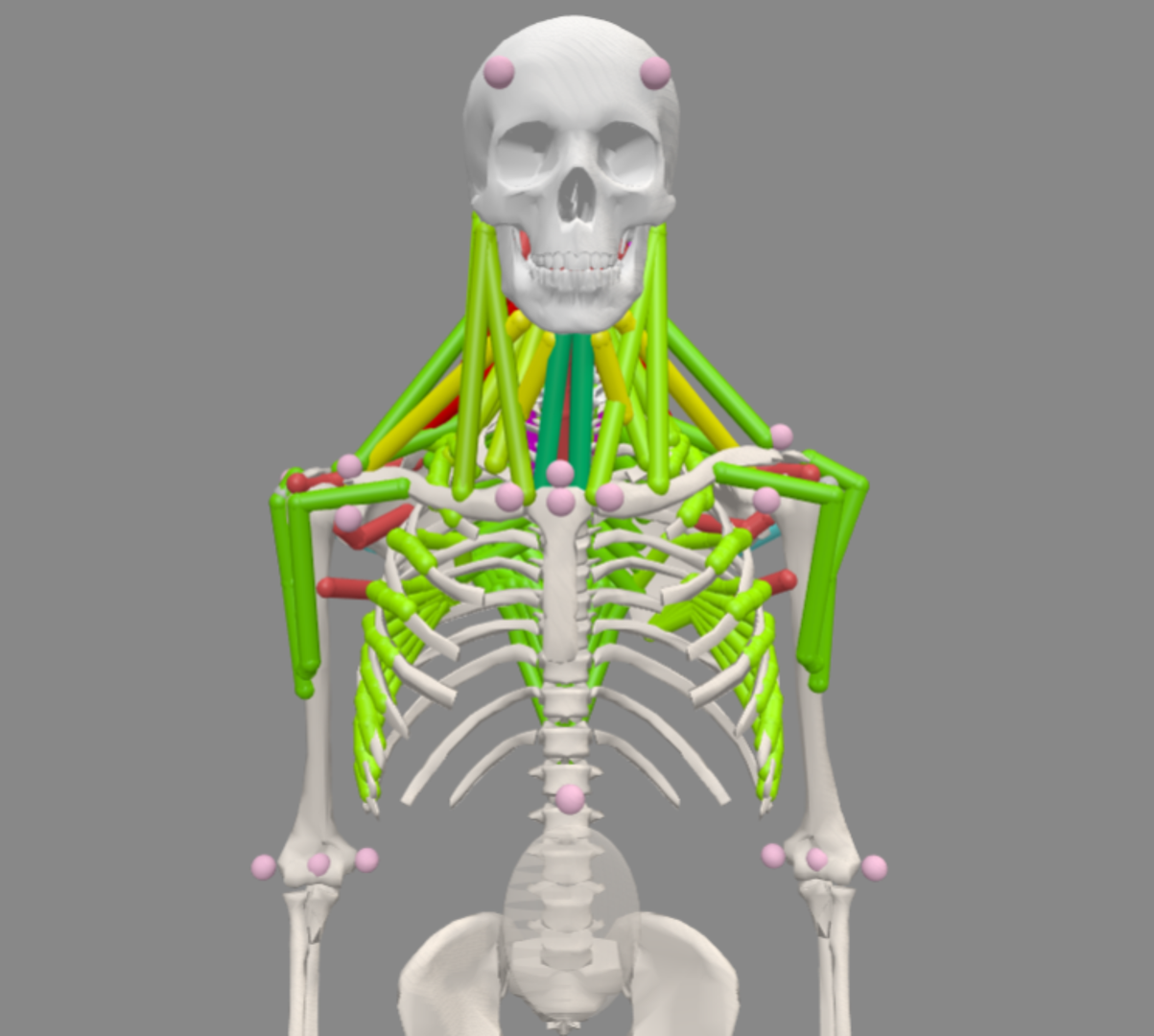

Опять обсуждали в чате gonzo-обзоров ход на третий шаг обучения LLM -- RL, тренировки на решение проблем. Проблема -- это когда ответ известен (например, теорема Ферма как гипотеза), а решение -- неизвестно (не доказана). Или ответ в партии Го известен -- "выигрыш", но как его получить -- непонятно, и там обычно дикая переборная задача, даже если не учитывать, что ответ можно искать не в жёстком мире булевой логики, а в существенно более мягком мире байесовской логики ("логики науки", как её называл Jeynes), а сейчас хорошо бы рассмотреть и квантовоподобную логику (которая тоже претендует на то, чтобы стать "мейнстримной логикой рациональности"). Это RL -- прорыв прорывов, ибо именно RL даёт ход на сверхчеловеческий разум, а не имитацию. Если брать RL для обучения, то дальше идём как в AlphaGo, которая породила в какой-то момент "37й ход", людям ранее не приходивший в голову. Вопрос только в достаточно мощном суперкомпьютере. При этом AlphaFold тоже нормально так решает задачи, которые людям недоступны. И R1 с прочими из этой серии — это как раз ход на вот такое. Поэтому я бы очень аккуратно писал про "недоступность чего-то такого, что доступно только людям". Нет такого, доступно всё — в том числе то, что недоступно людям. Я писал об этом в "Повтор балета R1 в исполнении simpleRL-reason", https://ailev.livejournal.com/1751437.html, а затем цитировал Andrey Karpathy в https://ailev.livejournal.com/1751581.html, затем описывал эту эволюцию нейросеток в "Как связаны инженерия и теория эволюции: инженерия нейросеток как eco-evo-devo", https://ailev.livejournal.com/1752137.html.В этих нейросетках, конечно, реализуется меметический алгоритм (https://en.wikipedia.org/wiki/Memetic_algorithm), то есть высказывание догадок (прыжок куда-то в пространство решений в надежде найти глобальный оптимум, стохастика), проверка догадок и уточнение их (ползём вычислительно на ближайшую вершину, пытаемся найти локальный оптимум). То, что в "очень многомерном пространстве" нейросеток проблем с нахождением глобального оптимума нет -- это не так, это ведь только для выпуклых функций верно, и там ещё и разные другие беды есть, которые как-то научились преодолевать (типа saddle points, https://arxiv.org/abs/1406.2572), так что идея меметических алгоритмов остаётся. Главное, что эти меметические алгоритмы оказываются наложенными на алгоритм самой нейросетки -- они оказываются познанными в ходе того самого обучения с подкреплением, RL, решения задач с ответом, но непонятными шагами решения. Высказывание догадок, самокритика, проведение экспериментов (например, поиск в Сети или даже работа с инструментами или хотя бы обращение к базам данных по каким-то API), модификация догадок, понимание неудачи с откатом назад и высказыванием новых догадок -- вот этот алгоритм познания оказывается эмерджентным, а потом ещё и эволюционирует. В любом случае, ход на R1, o3, Gemini 2.0 Thinking -- этот ход показывает, что можно сделать умную сетку, обучая по-новому. Более того, уже видны ходы, как её сделать ещё умнее (https://ailev.livejournal.com/1751264.html): уйти от токенов, в том числе рассуждения тоже делать во внутреннем коде (BLT, Coconut, DroidSpeak), а ещё сплавлять отдельные умные модели в одну ещё более умную (FuseAI). Проблема devo вроде как решена, но не просматривается open endedness, бесконечное поумнение, бесконечное познание, evo -- как перейти к настоящему бесконечному развитию? В open-endedness (https://ailev.livejournal.com/1463013.html) интересуются проблемой неостановимости эволюции, неостановимости прогресса, ибо в open-endedness примат познания, оно должно быть бесконечным, философский камень в этом. Естественная эволюция объявляется ближайшим нам известным алгоритмом, но ищутся варианты искусственные, желательно получше, чем естественные. Поскольку интересует не столько "вымирание", сколько познание, то берётся набор проблем, они решаются -- и ставятся новые проблемы на базе уже решённых. Развиваются (эволюционируют, evo) тем самым алгоритмы решения (это обеспечивается их получением и жизнью, devo) и развивается набор проблем, что проявляется в усложнении мира (eco), в котором действуют эволюционирующие агенты. Любое решение проблемы объявляется локальным оптимумом, а фишка в том, чтобы возможно было ставить всё новые и новые цели в "зоне ближнего развития" (goldilocks цели) — и ты быстро упираешься не в то, что нельзя придумать такой алгоритм плюс к нему достаточно сложную среду для предоставления непрерывно усложняющихся проблем, чтобы там процесс познания не останавливался, чтобы агент решал всё более и более крутые проблемы.Для того, чтобы эволюция работала, надо обратить внимание на eco, внешний мир. Тут слово "эволюция" важно, её понимают отнюдь не как "развитие" -- ибо там не прогресс, а динамический ландшафт приспособленности, увеличение сложности есть, а вот "прогресс" или "развитие" сомнительны, вымереть всегда легко, поэтому тусовка исследователей эволюции не говорит об эволюционном развитии, а говорит об эволюции, а

Это RL -- прорыв прорывов, ибо именно RL даёт ход на сверхчеловеческий разум, а не имитацию. Если брать RL для обучения, то дальше идём как в AlphaGo, которая породила в какой-то момент "37й ход", людям ранее не приходивший в голову. Вопрос только в достаточно мощном суперкомпьютере. При этом AlphaFold тоже нормально так решает задачи, которые людям недоступны. И R1 с прочими из этой серии — это как раз ход на вот такое. Поэтому я бы очень аккуратно писал про "недоступность чего-то такого, что доступно только людям". Нет такого, доступно всё — в том числе то, что недоступно людям. Я писал об этом в "Повтор балета R1 в исполнении simpleRL-reason", https://ailev.livejournal.com/1751437.html, а затем цитировал Andrey Karpathy в https://ailev.livejournal.com/1751581.html, затем описывал эту эволюцию нейросеток в "Как связаны инженерия и теория эволюции: инженерия нейросеток как eco-evo-devo", https://ailev.livejournal.com/1752137.html.

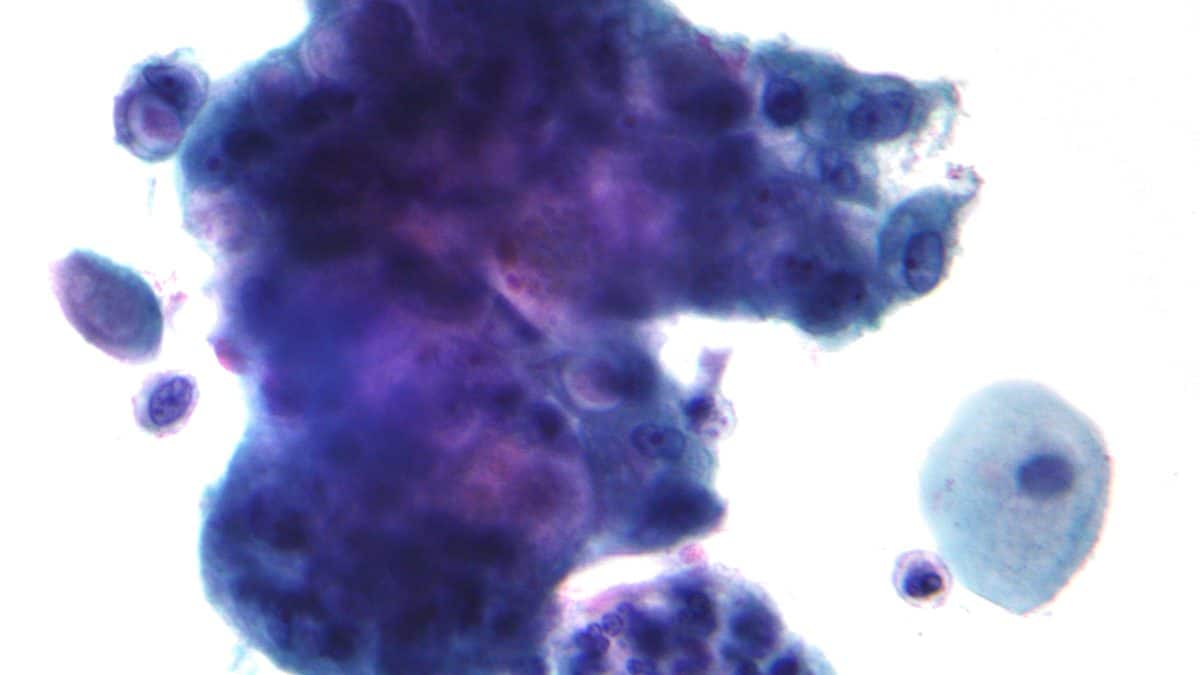

В этих нейросетках, конечно, реализуется меметический алгоритм (https://en.wikipedia.org/wiki/Memetic_algorithm), то есть высказывание догадок (прыжок куда-то в пространство решений в надежде найти глобальный оптимум, стохастика), проверка догадок и уточнение их (ползём вычислительно на ближайшую вершину, пытаемся найти локальный оптимум). То, что в "очень многомерном пространстве" нейросеток проблем с нахождением глобального оптимума нет -- это не так, это ведь только для выпуклых функций верно, и там ещё и разные другие беды есть, которые как-то научились преодолевать (типа saddle points, https://arxiv.org/abs/1406.2572), так что идея меметических алгоритмов остаётся. Главное, что эти меметические алгоритмы оказываются наложенными на алгоритм самой нейросетки -- они оказываются познанными в ходе того самого обучения с подкреплением, RL, решения задач с ответом, но непонятными шагами решения. Высказывание догадок, самокритика, проведение экспериментов (например, поиск в Сети или даже работа с инструментами или хотя бы обращение к базам данных по каким-то API), модификация догадок, понимание неудачи с откатом назад и высказыванием новых догадок -- вот этот алгоритм познания оказывается эмерджентным, а потом ещё и эволюционирует.

В любом случае, ход на R1, o3, Gemini 2.0 Thinking -- этот ход показывает, что можно сделать умную сетку, обучая по-новому. Более того, уже видны ходы, как её сделать ещё умнее (https://ailev.livejournal.com/1751264.html): уйти от токенов, в том числе рассуждения тоже делать во внутреннем коде (BLT, Coconut, DroidSpeak), а ещё сплавлять отдельные умные модели в одну ещё более умную (FuseAI). Проблема devo вроде как решена, но не просматривается open endedness, бесконечное поумнение, бесконечное познание, evo -- как перейти к настоящему бесконечному развитию?

В open-endedness (https://ailev.livejournal.com/1463013.html) интересуются проблемой неостановимости эволюции, неостановимости прогресса, ибо в open-endedness примат познания, оно должно быть бесконечным, философский камень в этом. Естественная эволюция объявляется ближайшим нам известным алгоритмом, но ищутся варианты искусственные, желательно получше, чем естественные. Поскольку интересует не столько "вымирание", сколько познание, то берётся набор проблем, они решаются -- и ставятся новые проблемы на базе уже решённых. Развиваются (эволюционируют, evo) тем самым алгоритмы решения (это обеспечивается их получением и жизнью, devo) и развивается набор проблем, что проявляется в усложнении мира (eco), в котором действуют эволюционирующие агенты. Любое решение проблемы объявляется локальным оптимумом, а фишка в том, чтобы возможно было ставить всё новые и новые цели в "зоне ближнего развития" (goldilocks цели) — и ты быстро упираешься не в то, что нельзя придумать такой алгоритм плюс к нему достаточно сложную среду для предоставления непрерывно усложняющихся проблем, чтобы там процесс познания не останавливался, чтобы агент решал всё более и более крутые проблемы.

Для того, чтобы эволюция работала, надо обратить внимание на eco, внешний мир. Тут слово "эволюция" важно, её понимают отнюдь не как "развитие" -- ибо там не прогресс, а динамический ландшафт приспособленности, увеличение сложности есть, а вот "прогресс" или "развитие" сомнительны, вымереть всегда легко, поэтому тусовка исследователей эволюции не говорит об эволюционном развитии, а говорит об эволюции, а развивается/developing у них только организм, популяции и организмы же адаптируются, но в целом всё -- эволюция, могучая и беспощадная. В тусовке open-endedness замечают при этом, что если не open-endedness, то не эволюция.

Предлагается за данными идти или в жутко сложные виртуальные миры (world models, синтетические данные -- это в какой-то мере оно, "виртуальный мир данных о реальном мире, Матрица с неизбежными глюками, не-реальность), но это паллиативы. Надо идти в бесконечно сложный и богатый данными для познания реальный мир, что ещё сложней похода в виртуальный мир, ибо требует роботов. Интеллект для бесконечной (а не затухающей) эволюции таки должен быть 4E (embodied, extended, embedded и enactive), биологи радостно замечают, что это и есть их eco-evo-devo (что даже для клетки организм — это экологическая ниша, и там черепахи до самого верха и до самого низа), а люди в AI говорят, что всё-таки проблема уже больше в эволюции не алгоритмов, а в эволюции данных.

То есть алгоритмически вполне можно заниматься междисциплинарными исследованиями, но вопрос в эволюции данных для познания (я упорно перевожу learning в self-supervised learning как "познание", посколько это "без учителя"). От банальных параллелей типа https://arxiv.org/abs/1706.05714 и https://arxiv.org/abs/2308.14591 до печальных замечаний людей типа Stanley и Lehman, что богатыми мирами для AI (то бишь данными) мало кто занимается. Вот видео панели по open-endedness: https://www.youtube.com/watch?v=hr_7SLG3GDA. Kenneth Stanley с другими исследователями ругают reinforcement learning и neural network, подчёркивают недоизученность алгоритмов эволюции и влияния мира такого, каков он есть (среды для агентов) на бесконечное развитие. Проблема не столько в отсутствии вычислительных ресурсов по сравнению с реальным миром и реальной эволюцией, но именно в непонимании алгоритмики эволюции и свойств вселенной, которая вдруг ухитрилась сделать эту эволюцию. А ещё появился интеллект, и сшиб все карты -- но важно понимать, что до интеллекта, до нейронных сетей с эволюцией всё тоже было в порядке, она происходила. Саму open-endedness Stanley понимает как continual generation of artifactics that are interesting to us without bound forever.

При этом система сама должна учиться, ибо мы вряд ли сможем дать какой-то отклик на обстоятельства этой бесконечно развивающейся системы в ходе обучения, эти обстоятельства/проблемы же будут для нас новыми! А сама система тоже никогда не сможет адаптироваться и генерализовать описание мира существенно, ибо мир-то всё время новый! Проблема в том, что миры для open-endedness и алгоритмы сейчас небогаты, и мы не видим чего-то такого, чего мы бы не могли предвидеть (все эти "прятки агентов" и EnhancedPOET и прочие демонстрации). Но бесконечное развитие нам нужно как раз для того, чтобы появилось что-то такое, что мы не могли бы предвидеть!

Stanley говорит, что мы вроде как вышли на плато с нынешними системами, и дело не в том, что у эволюции миллиарды лет, а текущие системы имеют очень небольшое вычислительное время, а в том, что эти системы выходят на "потолок в развитии". Все они там призывают иметь среды посложней и цели (в отличие от reinforcement learning с его наградами) поразнообразней. Environment design is basically like completely virgin territory, because no experts on this, no study, no theory, nobody knows anything about this. Последняя работа, https://arxiv.org/abs/2501.13075 "Evolution and The Knightian Blindspot of Machine Learning", в которой даётся отсылка к Knightian uncertainty (в экономике это различение риска -- знание того, что могло бы произойти, от полного незнания того, что могло бы произойти -- https://en.wikipedia.org/wiki/Knightian_uncertainty). Делается утверждение, что AI сегодня на базе RL -- это исключительно оптимизация для известного (поиск локального максимума), а не эволюционный/меметический алгоритм, который мог бы приспособиться к полностью неизвестному. Доказательства: "автомобиль, выученный водить в США, не сможет водить в Великобритании, а вот люди -- вполне справляются". Ну, и дальше в примерах там эволюция, а спасёт всех open-endedness.

Если показывать людям из open-endedness направление world models (а хоть и лидера -- Genie 2.0, https://deepmind.google/discover/blog/genie-2-a-large-scale-foundation-world-model/), то они только печально улыбаются в ответ, ибо в world models пока не заводится "бесконечное eco-evo-devo", и вообще эти "модели мира" с грубой имитацией хорошо видимых физических объектов породит только что-то типа ньютоновской физики, не более. Чтобы познать реальную физику, нужен доступ к реальному миру!

Но вот про RL всё не так просто: действительно, до сегодняшнего дня для МLLM (а multimodal LLM даёт интеллект -- высокую универсальность по всем предметным областям, "эрудированность") не получалось учить с RL. Я видел огромное число откликов на работу по R1 с содержанием вроде "и я этим занимался, это ж всё в воздухе витало, но результат не смог получить, и бросил. Респект команде DeepSeek, они таки смогли, проложили всем дорогу". Скорее всего, какой-то вариант RL потребуется для решения проблем в рамках open-endedness проектов -- но помним, что фишка там в развитии мира, развитии eco, развитии environment. R1 и аналогичные системы смягчают критику алгоритмов RL -- но люди в open-endedness мягко намекают, что плохо понятно, что там reward. Во внешнем мире понятно -- не "решение задачи", а избегание неприятного сюрприза, это active inference и вся эта линия рассуждений с минимумом свободной энергии. Но всё равно, по пути от реального мира к решению в нём проблем стоит сначала задача создания интересного мира -- чтобы вечно не изучать пустыню Гоби, вечно не изучать мегаполис, но иметь continual generation of artifactics that are interesting to us without bound forever.

Я тут сказал, что для мокрых нейросеток делаем курсы — так вот с миром для обучения там тоже проблемы, более чем больные. Материал курса (pretrain) легко написать, задачки с пошаговыми решениями (примеры, finetune) — легко, а вот дальше завести RL не удаётся, ибо непонятно, что такое "решил проблему", непонятно, как задать функцию награды. Работает только вариант "когда я натыкаюсь на ответ — я узнаю это, и все вокруг узнают, и сразу всё хорошо, вот это и будет "правильный ответ", запомним". Поэтому планируем тренировки с "хватанием за язык" на примерах собственных проектов из реальной жизни (скажем, как в игре барышня-мадам, https://ailev.livejournal.com/1750301.html). Без доступа к реальному миру обучения у нас не получалось, на бизнес-кейсах с образцами пошаговых решений, как в других вузах, обучение шло плохо -- там идёт имитационное обучение, учат не думать и развивать своё мышление, учат имитировать чужое мышление для получения похожих ответов. Ответ подсказывают люди из open-endedness: учить надо на проблемах реального мира, реальных проектах. Поумнение там. Вот и продолжим.

Я к этой теме в прошлый раз подходил ещё в 2022, в связи с разговорами об измерении интеллекта -- "Измерение интеллекта: занимаемся миром/средой/окружением/контекстами/domain, становимся демиургами", https://ailev.livejournal.com/1609242.html

Картинка из ещё августовской 2024 статьи "Open-endedness is all we'll need", https://press.airstreet.com/p/open-endedness-is-all-well-need. Поглядите, там всё те же "три шага обучения" -- это всё носится в воздухе, просто, как и в нормальной эволюции, у некоторых проектов получается выжить, а у некоторых догадки оказываются неправильными. "Момент DeepSeek" получился не только из-за правильной догадки о том, как выучивать меметический алгоритм с догадками и самокритикой/рефлексией в нейросетке с LLM, но и из-за того, что там всё выложили в опенсорс. Но это ещё не последний фронтир, дальше open-endedness, а для этого выложить в опен сорс надо генератор миров, генератор артефактов, генератор проблем. Агенты, да, это у всех сейчас агенты. Но агенты агентам рознь, нам нужны непрерывно умнеющие агенты. И коллективы агентов, которые могут познавать совместно. Ну, участвуем, а не ждём, пока "они там пусть сделают". Помним, что в распоряжении каждого из нас есть мокрая нейронная сетка, в которой работает неплохая LLM, она уже pretrained и даже finetuned, теперь её надо научить думать, а потом научить думать лучше, а потом... и мы опять упираемся в open-endedness, is all we'll need. Так что я хоть и не обучаю нежить, но с обучением нейронных сеток сталкиваюсь каждый день. Мопед мой.

UPDATE: дискуссия в чате блога -- https://t.me/ailev_blog_discussion/29323

Скорее всего, я достаточно мутно написал, ибо писал в надежде, что с open-endedness все или знакомы, или пройдут по ссылке на мой текст и другие тексты -- но вот нет, так не получилось. Не все поняли основную идею поста -- чем эти "агенты потом" отличаются от великолепных "агентов сейчас".

Ключевое тут — это "кто-то должен придумать задачу и правило определения правильного ответа" и там добавляется условие, что мир должен быть достаточно сложным, чтобы это могло работать бесконечно (скажем, решение предыдущей задачи чуток усложняет мир, и можно брать новую проблему — чуток посложнее). И там, конечно, простейшие миры поначалу подходят. Потом — модели реального мира. Потом оказывается, что только реальный мир подойдёт. Но фишка в том, что в текущей парадигме задачи ставят люди, а агенты только учатся их решать. В open-endedness два трека (можно грубо считать, что два агента): один решает проблемы, а другой их ставит. И тут оказывается, что интересные проблемы в простых мирах быстро заканчиваются. И самое неизведанное — это постановка нетривиальных проблем.

Повторюсь (у меня на эту тему были посты): поскольку непонятно в математике, что такое "интересная проблема", то самые крутые математики приобретают интуицию, что это такое, интуицию интереса. И там крутыши решали проблемы, а потом, доказав тем самым, что они крутыши, ставили новые более сложные проблемы — оставляли новому поколению. И так цикл повторялся. Рома Михайлов дико ругал Перельмана, ибо тот доказал, что крутыш — доказал теорему Ферма. А потом не поставил новой интересной проблемы тем, кто идёт за ним. А должен бы! Без этого "трека постановки проблем" нет open-endedness, решили все интересные проблемы, и эволюция закончилась.

Вот агенты сейчас не ставят проблемы, они их только решают, их учат только решать проблемы, которые ставят им другие люди. Их нельзя оставить с огромными вычислительными ресурсами, чтобы они бесконечно совершенствовались (ибо нет автоматизации порождения интересных задач, нет автоматизации порождения новизны в плане задач — новизна в плане решений задач тут не та новизна). В этом плане всякие AlphaGo и то выглядят круче — там агенты играли друг с другом, каждым ходом ставя друг другу загадку.

Я бы очень условно предложил такое: есть гениальные проектировщики/конструкторы, они для любой функции, которую предлагает методолог, догадываются, как её реализовать из подручных материалов, а иногда и материалы придумывают. А есть методолог, который придумывает, что бы такого реализовать — придумывает функциональные описания интересных устройств, которые выполняют интересные функции.

Вот нынешние агенты — это гениальные изобретатели, похлеще ТРИЗовцев, а гениальных методологов, которые заглядывают в будущую функциональность — их вот что-то нет.

Повторюсь: акцент не на определение того, какое решение правильное (какая функция награды), акцент на определение того, какая проблема правильная, какую проблему стоит решать.

Ну, и ремарка про терминологию: задача — это когда понятно, как решать. А проблема — это когда непонятно, как решать (и интеллект как устройство, переводящий проблемы в задачи). Вот с текущим уровнем интеллекта вроде всё ОК, с бесконечной эволюцией интеллекта пока — не очень.