Исследования AI в январе 2025: по-прежнему всё бодренько

У меня в чате блога Artem Mārīcī пишет: "Как бы не оказалось, что выйдет Зак или Маск и скажет: каждый раз, когда я увольняю ИИ саентиста качество модели растет, а стоимость создания и эксплуатации падают" (https://t.me/ailev_blog_discussion/28913). Это аллюзия на "каждый раз, когда я увольняю лингвиста, качество перевода растёт". Поэтому сказано просто, что ИИ саентисты — у них сегодня не та наука, которая сейчас продвигает. DeepSeek R1 (https://github.com/deepseek-ai/DeepSeek-R1) -- это, конечно, крутой момент в истории. Помним, что Tony Seba говорил про экспоненциальный рост в части распространения технологии, а топливом этого роста является экспоненциальное падение цены. Цена на приличный интеллект для R1 упала драматически. По сути дела, снимается ограничение на объём данных для обучения: модели учатся исследовать, за что получают конфетку -- это reinforcement learning (как с моделями Alpha от DeepMind, это которые выиграли в Го и в сворачивание белков), причём в его self-supervised варианте, ну, или каких-то более мягких вариантах, где поначалу учитель, а уж дальше -- всё сама, всё сама. Сегодня самое обсуждаемое -- это:-- Kimi (https://github.com/MoonshotAI/Kimi-k1.5/blob/main/Kimi_k1.5.pdf) DeepSeek does AlphaZero approach - purely bootstrap through RL w/o human input, i.e. "cold start". Kimi does AlphaGo-Master approach: light SFT to warm up through prompt-engineered CoT traces. Хотя DeepSeek опубликовало веса, а Kimi Team -- нет, там пока пусто. Но тоже показывают характеристики уровня o1 и выше. Там решили, что надо масштабировать окно контекста для обучения с подтверждением, и дошли до 128К, и это оказалось ключевым. В статье подчёркивается, что там не CoT, а long-CoT. В итоге не надо специально программировать планирование, рефлексию и исправление ошибок, они "самозаводятся" -- strong performance can be achieved without relying on more complex techniques such as Monte Carlo tree search, value functions, and process reward models. Это назвали simplistic framework. Ну, и вишенка на торте -- обучали на тексте и картинках, поэтому может рассуждать совместно на двух модальностях. Новая терминология: 4o это short-CoT, а o1 -- long-CoT.-- TinyZero (https://github.com/Jiayi-Pan/TinyZero): повторение DeepSeek R1-Zero на 3B LM , и оно просто работает -- hrough RL, the 3B base LM develops self-verification and search abilities all on its own. You can experience the Ahah moment yourself for < $30.Ещё одна интересная штука последнего месяца -- это исследование в эффективном языке для мышления. В принципе, "произнесённое дао -- не настоящее дао". В моделях типа o1 (long-CoT) мышление идёт "на родном языке", промежуточные рассуждения делаются на том же языке, что входной и выходной -- те же токены, даже не в профиль. В Meta делаются попытки отойти от токенизации:-- первый же ход был на patches (сегменты, самые разные LLM хором говорят, что это лучший перевод термина в сфере ML) вместо токенов: "Byte Latent Transformer: Patches Scale Better Than Tokens", https://arxiv.org/abs/2412.09871. Это нужно для масштабирования: for fixed inference costs, BLT shows significantly better scaling than tokenization-based models, by simultaneously growing both patch and model size. Но это всё одно сегменты входного языка.-- второй ход -- Coconut (https://github.com/facebookresearch/coconut, https://arxiv.org/abs/2412.06769), мышление прямо в терминах латентного пространства, "непрерывное", без лишних шагов для "перевода" скрытых представлений в текст на промежуточных шагах. Это отход от классического CoT в тех задачах, где много бэктрекинга: This novel latent reasoning paradigm leads to emergent advanced reasoning patterns: the continuous thought can encode multiple alternative next reasoning steps, allowing the model to perform a breadth-first search (BFS) to solve the problem, rather than prematurely committing to a single deterministic path like CoT. Coconut outperforms CoT in certain logical reasoning tasks that require substantial backtracking during planning, with fewer thinking tokens during inference. Coconut consistently outperforms traditional CoT and other methods across various reasoning tasks, indicating its robustness and adaptability (вот тут простыми словами: https://www.getmaxim.ai/blog/llms-continuous-latent-spaces/). Кратко, instead of mapping between hidden states and language tokens using the language model head and embedding layer, Coconut directly feeds the last hidden state (a continuous thought) as the input embedding for the next token. Вот проверочная работа: https://github.com/vicksEmmanuel/latent-gemma (подтвердили улучшение множества метрик при переходе на "непрерывные мысли", continuous thoughts).-- для меня эта линия ещё и продолжение линии DroidSpeak, https://arxiv.org/abs/2411.02820, это седая древность уже, аж ноябрь 2024 года!-- ... а вот для людей с этим проблемки, ибо выкладывать в экзокортекс для запоминания промежуточных результатов приходится таки слова, даже не цепочки ток

-- Kimi (https://github.com/MoonshotAI/Kimi-k1.5/blob/main/Kimi_k1.5.pdf) DeepSeek does AlphaZero approach - purely bootstrap through RL w/o human input, i.e. "cold start". Kimi does AlphaGo-Master approach: light SFT to warm up through prompt-engineered CoT traces. Хотя DeepSeek опубликовало веса, а Kimi Team -- нет, там пока пусто. Но тоже показывают характеристики уровня o1 и выше. Там решили, что надо масштабировать окно контекста для обучения с подтверждением, и дошли до 128К, и это оказалось ключевым. В статье подчёркивается, что там не CoT, а long-CoT. В итоге не надо специально программировать планирование, рефлексию и исправление ошибок, они "самозаводятся" -- strong performance can be achieved without relying on more complex techniques such as Monte Carlo tree search, value functions, and process reward models. Это назвали simplistic framework. Ну, и вишенка на торте -- обучали на тексте и картинках, поэтому может рассуждать совместно на двух модальностях. Новая терминология: 4o это short-CoT, а o1 -- long-CoT.

-- TinyZero (https://github.com/Jiayi-Pan/TinyZero): повторение DeepSeek R1-Zero на 3B LM , и оно просто работает -- hrough RL, the 3B base LM develops self-verification and search abilities all on its own. You can experience the Ahah moment yourself for < $30.

Ещё одна интересная штука последнего месяца -- это исследование в эффективном языке для мышления. В принципе, "произнесённое дао -- не настоящее дао". В моделях типа o1 (long-CoT) мышление идёт "на родном языке", промежуточные рассуждения делаются на том же языке, что входной и выходной -- те же токены, даже не в профиль. В Meta делаются попытки отойти от токенизации:

-- первый же ход был на patches (сегменты, самые разные LLM хором говорят, что это лучший перевод термина в сфере ML) вместо токенов: "Byte Latent Transformer: Patches Scale Better Than Tokens", https://arxiv.org/abs/2412.09871. Это нужно для масштабирования: for fixed inference costs, BLT shows significantly better scaling than tokenization-based models, by simultaneously growing both patch and model size. Но это всё одно сегменты входного языка.

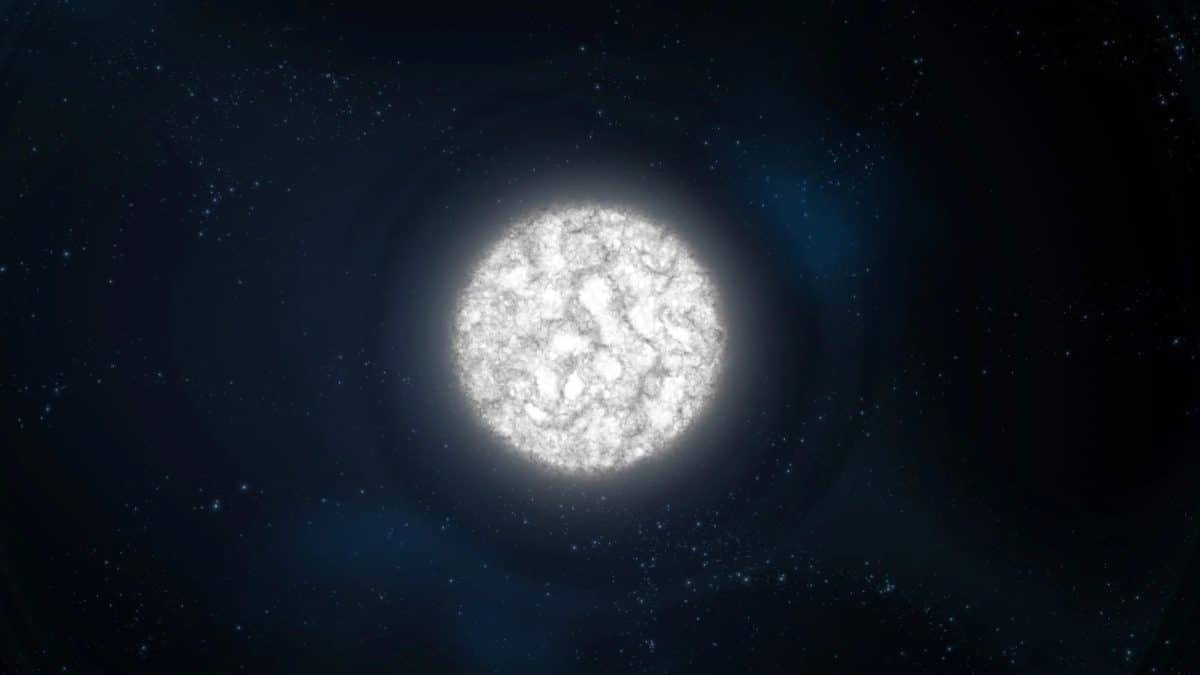

-- второй ход -- Coconut (https://github.com/facebookresearch/coconut, https://arxiv.org/abs/2412.06769), мышление прямо в терминах латентного пространства, "непрерывное", без лишних шагов для "перевода" скрытых представлений в текст на промежуточных шагах. Это отход от классического CoT в тех задачах, где много бэктрекинга: This novel latent reasoning paradigm leads to emergent advanced reasoning patterns: the continuous thought can encode multiple alternative next reasoning steps, allowing the model to perform a breadth-first search (BFS) to solve the problem, rather than prematurely committing to a single deterministic path like CoT. Coconut outperforms CoT in certain logical reasoning tasks that require substantial backtracking during planning, with fewer thinking tokens during inference. Coconut consistently outperforms traditional CoT and other methods across various reasoning tasks, indicating its robustness and adaptability (вот тут простыми словами: https://www.getmaxim.ai/blog/llms-continuous-latent-spaces/). Кратко, instead of mapping between hidden states and language tokens using the language model head and embedding layer, Coconut directly feeds the last hidden state (a continuous thought) as the input embedding for the next token. Вот проверочная работа: https://github.com/vicksEmmanuel/latent-gemma (подтвердили улучшение множества метрик при переходе на "непрерывные мысли", continuous thoughts).

-- для меня эта линия ещё и продолжение линии DroidSpeak, https://arxiv.org/abs/2411.02820, это седая древность уже, аж ноябрь 2024 года!

-- ... а вот для людей с этим проблемки, ибо выкладывать в экзокортекс для запоминания промежуточных результатов приходится таки слова, даже не цепочки токенов. Про нейроинтерфейсы я тут писать не буду, там сейчас акцент не на латентные представления, а ровно наоборот -- как вытаскивать внешнее языковое представление. Ну, или внешнее картиночное представление, но никак не "мысли в нативной форме". При этом "долго медитировать безмолвно внутри себя" -- это тупик, много в таком режиме не надумаешь, хотя математики могли бы с этим поспорить, но всё одно математики пишут в ходе размышлений, а "однобуквенные идентификаторы с индексами и штрихами" как мат.нотация -- это для них такая стенография, скоропись.

Попытки выхода на "спросить их все" (учитываем, что согласно теоремы бесплатного обеда, супер-пупер-универсальной нейросетки для всех-всех задач не может быть, поэтому хорошо бы идти по пути библиотек -- у меня тут всегда пример Julia подхода к сбору всяческих "библиотек" навроде JuMP и SciML в Julia (они их кличут DSL, https://jump.dev/JuMP.jl/stable/, https://docs.sciml.ai/Overview/stable/overview/ -- фишка в том, что собрано много уникальных алгоритмом "для частных случаев", и утверждается, что "жизнь такая, что всё у нас частные случаи, общих методов решения нет, эта философия хорошо прописана в статье Gary Markus и Douglas Lenat https://arxiv.org/abs/2308.04445). И вот пошли работы:

-- llm consoritum (https://github.com/irthomasthomas/llm-consortium), там просто обращаются к коммерческим LLM и просят прийти к консенсусу.

-- FuseAI (https://github.com/fanqiwan/FuseAI), берём всякое открытое и сплавляем (fuse) из нескольких открытых моделек послабее одну покруче, после чего соревнуемся с proprietary типа o1, и соревнуемся вполне успешно.

-- самые разные методы model merging, https://developer.nvidia.com/blog/an-introduction-to-model-merging-for-llms/

-- ... много такого, но я считаю, что добавить человека, или даже команду -- это идти по этой же линии. Более того, добавить робота, который может поглядеть что-то в физическом мире (сделать эксперимент, что-то спросить, принести новое знание) -- это поход по этой же линии.

И повторю тут кусочек из вчерашнего поста (я не думаю, что кто-то нашёл этот кусочек в https://ailev.livejournal.com/1750940.html) -- это про то, что текущая ситуация с AI алгоритмами долго не продержится (в принципе, скорость алгоритмов прирастает больше, чем скорость аппаратуры. Поэтому улучшения в алгоритмах будут давать не меньший, а больший эффект, чем строительство датацентров -- хотя все датацентры будут при деле, более быстрым алгоритмам всё равно надо будет дать время и энергию на "подумать"). Вот: AI-блогеры из обозревателей "разработки AI" стали тупо усилителями пресс-службы OpenAI -- не надо много лет заниматься разработкой систем AI, чтобы живописать фичи очередных версий пользовательских продуктов. Впрочем, я это уже говорил -- но потихоньку перешёл к действиям, ищу новых блогеров, где можно что-то прочитать про происходящее "под капотом" (вот, например, "LLM под капотом", так и называется -- https://t.me/llm_under_hood, там по счастью не пишут "вау! оператор! вы этого ещё не слышали от ваших кофейников и холодильников! вам это ещё не завирусилось!", там пишут про "аккуратное построению reasoning систем из небольших тестируемымых логических блоков с LLM под капотом"). Я бы живописал многоуровневую эволюцию систем AI, показывая эволюцию на каждом уровне. Где взять уровни? Ну, у меня в курсе "Методология" есть картинка (https://aisystant.system-school.ru/lk/#/course/methodology/2024-11-27T2259/51563) с уровнями, но тут самое интересное, конечно -- это ломка самой картинки. Следы этой ломки вполне заметны:

-- абсолютно голословное заявление LeCun про приход новой архитектуры (тут это -- функциональная организация, но в том числе отсюда следует и "форма следует за функцией", то есть конструктивные изменения) AI в течение 5 лет. Ну, и приход робототехники -- не LLM только жив человек, парадокс Моравека вроде как более-менее успешно решается. Вот: https://techcrunch.com/2025/01/23/metas-yann-lecun-predicts-a-new-ai-architectures-paradigm-within-5-years-and-decade-of-robotics/. Хотя сам LeCun тут в деле, вот месячной давности его новости по JEPA: https://arxiv.org/abs/2412.10925, там поднимается опять старинный термин representations learning, заголовок там "Video Representation Learning with Joint-Embedding Predictive Architectures", сравнивается с порождающими архитектурами (теми же трансформерами). Ключевая разница -- познанные (learned) в ходе исследований (познания-без-учителя) представления видео, что ведёт к пониманию сложных видео при уменьшенном вычислительном бюджете. Это всё про компьютерное зрение для роботов. Я тут попытался делать работу "перевода на понятный" терминологии ML, ибо эта терминология тащится там с доисторических времён, термины эти обрастают разными модификаторами и понимания окончательно теряется. Вот руки чешутся все эти "ренормализованные нейроны" и "скрытые представления" на внятном языке рассказать, а не на птичьем.

-- в этом же направлении R1, ибо там "за копейки победили гигантов", https://venturebeat.com/ai/why-everyone-in-ai-is-freaking-out-about-deepseek/. Причём это не "все китайцы обгонят американцев", там другой феномен -- это pet-проект утилизации свободных GPU в компании-трейдере, https://x.com/hxiao/status/1882649545982849031. "Всё новое приходит сбоку", ага -- и все на ушах.

-- Francois Chollet покинул Гугл (https://developers.googleblog.com/en/farewell-and-thank-you-for-the-continued-partnership-francois-chollet/) и пошёл в https://ndea.com/, где надеется на прорыв в синтезе программ эволюционными алгоритмами, которые направляются глубоким обучением -- ибо уже достаточно компьюта, старые алгоритмы на крупном компьюте вполне могут показать себя по-новому. Особенно, если к ним добавить глубокое обучение. Compared to deep learning, program synthesis is a much less mature research field. The state of program synthesis in 2025 looks a lot like deep learning circa 2012. But we are not alone in recognizing the potential of program synthesis — it's a technique every frontier AI lab is now starting to explore. Most, however, believe it's only a small component of what's needed for AGI. We believe program synthesis and deep learning are equally important. We're starting Ndea — an AI research and science lab. The name - like 'idea' with an 'n' - is inspired by the Greek concepts ennoia (intuitive understanding) and dianoia (logical reasoning), capturing our first goal to merge deep learning with program synthesis. Ndea is entirely focused on developing and operationalizing AGI to realize unprecedented scientific progress in our lifetime for the benefit of all current and future generations. Building AGI alone is a monumental undertaking, but our mission is even bigger. We're creating a factory for rapid scientific advancement — a factory capable of inventing and commercializing N ideas.

-- Тем временем, на прикладном фронте тоже идут подвижки. Вот "AutoCBT: An Autonomous Multi-agent Framework for Cognitive Behavioral Therapy in Psychological Counseling", https://arxiv.org/abs/2501.09426. Понятно, что тут модно двигается SoTA (бенчмаркинг не на живых пациентах, а на проф. психологах, оценивающих ответы). И тут забавная деталь: Llama оказывается хуже Qwen -- During a psychological counseling simulation, the Llama model refuses to answer nine questions from the English portion of the dataset related to minors, sex, and suicide, a behavior also observed in both AutoCBT and baselines. In contrast, the Qwen model answers all questions of the bilingual dataset. After excluding the nine questions that Llama refuses to answer, we analyze AutoCBT’s effectiveness using the Llama model on the remaining 91 questions. Qwen performs signifcantly better. In baseline scenarios, Llama consistently refuses to answer sensitive questions, fails to recognize the user’s need for psychological support, and signifcantly harms the user experience. When deploying online psychological counseling services, Llama’s excessive caution can cause users seeking help to feel misunderstood, potentially worsening cognitive distortions. Благими намерениями вымощена дорога в ад. Это они ещё не общались с ГигаЧатом, я проверял лично -- там на половину вопросов нет ответа, "смените тему, на эту тему не буду разговаривать" ("что у меня чешется в носу?" -- "это медицинский вопрос, не намерен отвечать", "как приготовить свинину в апельсинах" -- "подозреваю, что тут чьё-то оскорбление, такие темы запрещены", и так бесконечно).

И на закуску: вот это как-то невидимо пока, но они там говорят, что их метод даёт выигрыш в скорости и памяти больше x2 по методу Decompute по сравнению с Softmax на том же DeepSeek, и они быстро-быстро набирают людей в команду -- https://x.com/DecomputeAI/status/1881777153097998727. Пост этот почти никто не видел, никакой другой информации нет, пейперов тоже -- но это ещё одна иллюстрация к тому, что движ с алгоритмами в полном разгаре. Но попсовые AI-блогеры перестали о таком писать, а жаль: про o3 расскажут из каждого утюга, а они бы могли перестать быть этими утюгами. Рассказывать о том, что только они могли бы рассказать с их уникальным опытом. А "я протестировал очередную фичу продукта OpenAI" -- это уже не новости фронтира, это новости того, что было фронтиром год назад, а сейчас просто докатилось до широкой публики, стало попсой. Эх, мне бы самому не опопсеть, очень не хотелось бы.

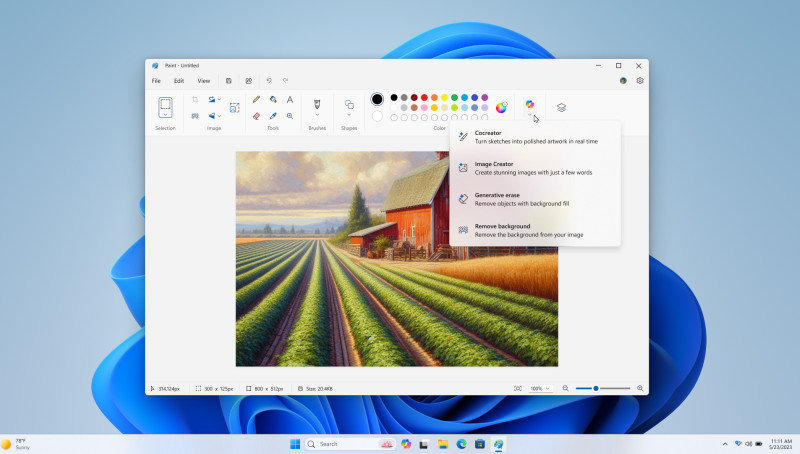

Картинка про continuous thoughts, "изречённое дао -- не настоящее дао":