Briefing 247: Deepseek R1 und Europa

R1 + Huawei, Geopolitische Dimension, Europa, AI Act

Hi,

aufgrund von Krankheit wurde die Erscheinungsfrequenz des Briefings leider etwas durcheinander gewirbelt. Deshalb erscheint dieses Freitagsbriefing noch einmal öffentlich. Nächste Woche macht das Briefing Pause.

Mittelfristige Aussicht: Nach dem erfolgreichen Umzug des CMS hinter neunetz.com gibt es noch einige Aufräumarbeiten im Hintergrund, die aktuell stattfinden. Gleichzeitig hat die Arbeit an neuen Formaten begonnen. Stay tuned.

Marcel

Im Fokus dieser Ausgabe:

- Deepseek R1: Chinesisches KI-Modell erreicht OpenAI-Niveau zu 1/10 der Kosten; bedeutender Schritt für China als KI-Macht und potenzielle globale Stärkung der chinesischen Chip-Industrie durch Huawei-Integration

- Europäische KI-Perspektive: R1 zeigt Europas schwache Position im KI-Wettbewerb; bietet aber auch Chancen für spezialisierte Modelle und neue Geschäftsmodelle wie bei Aleph Alpha

- AI Act: Europäische KI-Regulierung wird durch effiziente Modelle wie R1 weiter ausgehebelt; globaler Regulierungsansatz wäre nötig, oder zumindest ein anderes, realistisches Regulierungsziel.

- Kurzmeldungen: Perlentaucher wird 25 Jahre alt; TikTok Shop plant Deutschland-Start für Q2; News-Content auf TikTok gewinnt an Bedeutung

- und mehr

Zitat des Tages

Da mag man über die Technologie stöhnen, so viel man will. Sie steigert unsere Selbstachtung und verbindet uns in unseren wohlgebügelten Anzügen mit den Dingen, die ansonsten unbemerkt durch die Welt schlüpfen würden.

Aus Don DeLillos "Unterwelt"

Deepseek R1

Deepseek R1 analysiert

Deepseek R1 is AI's Sputnik moment.

R1 erreicht o1-Niveau zu einem Zehntel der Nutzungskosten und als semi-offenes Modell mit MIT-Lizenz. So weit, so bekannt.

Für die FAZ habe ich eine ausführliche Analyse über R1 geschrieben. Warum das Modell wichtig ist, was es besonders macht und wer nach dieser Verschiebung der KI-Landschaft zu den Gewinnern und Verlierern zählt.

Die Gewinner:

- Huawei: R1 unterstützt direkt deren Ascend-Chips, Deepseek-Modelle werden damit zum Komplementärgut für die chinesische Chipindustrie. Immense geopolitische Implikationen

- Hyperscaler wie Azure, AWS, Google Cloud

- "Wrapper" & Implementierer

- Mistral, andere Open Source Anbieter

Die Verlierer:

- OpenAI: Massiver Preisdruck

- Anthropic & Co: Proprietäre LLMs ohne OpenAIs Marke werden es sehr schwer haben

- AI Act: R1 zeigt noch einmal deutlich, wie hart der AI Act schon gescheitert ist

Ambivalent:

- Nvidia: Effiziente Modelle wie R1 werden mittelfristig den Bedarf nach KI-Rechenpower eher steigen lassen denn senken. Weil: Preiselastizität, für ökonomische Laien: Jevons-Paradoxon. :) Aber: Deepseek-Huawei scheint mir noch völlig unterschätzt zu werden. Alle (!) chinesischen Modellanbieter haben ein Interesse, ihre Modelle für Nicht-Nvidia-Chips zu optimieren.

- Nicht nur für Meta, im Grunde für alle, die an KI arbeiten: Ob Deepseek sich positiv oder negativ auswirkt, hängt stark davon ab, wie gut und schnell die Teams aus den Papern des chinesischen Labs lernen können. Wenn gut, dann senkt Meta damit seine Kosten massiv, wenn schlecht, dann verliert Meta das globale Ökosystem, das sie mühsam mit Llama aufgebaut haben.

Das und sehr viel mehr ausführlich im Text: Deepseek R1: Gewinner und Verlierer nach dem KI-Erdbeben

Ein paar Dinge möchte ich hier noch einmal separat hervorheben. Es wurde diese Woche viel über R1 gesprochen. Innerhalb dieses Rauschens sind die wichtigsten Aspekte untergegangen.

Ein Trend, kein Endpunkt

R1 ist ein Datenpunkt auf einer Trendlinie.

R1 ist zwar ein großer Schritt in Richtung effizienterer KI-Modelle. Aber diese Entwicklung findet statt, seit ChatGPT Ende 2022 erschien. R1 ist "lediglich" ein überraschend großer Schritt in dieser Richtung gewesen.

Skaleneffekte, Lerneffekte im Wertschöpfungsnetzwerk als auch sich verschiebende Kostenverteilungen sind etwas, auf das man sich immer verlassen kann.

Deepseeks R1 ist weder das erste gute chinesische Modell, noch wird es das letzte chinesische Modell sein. R1 hat mehrere Trends beschleunigt: Semi-offene Modelle, Qualitätssteigerung und Kostensenkung, China als wichtiger KI-Player.

Erster entscheidender Aspekt: Ein "offenes" Modell, die Reasoning-Token im Interface

Weil Deepseek unter anderem R1 als semi-offenes Modell bereitgestellt hat, bringt es eine wesentliche Veränderung mit.

Als OpenAI mit o1 letztes Jahr sein erstes Reasoning-Modell vorstellte, war das aus mehreren Gründen ein Paradigmenwechsel. Sie haben mit dem Fokus auf die Inferenzzeit (Rechenzeit nach Input) gezeigt, welche Sprünge in der Outputqualität erzielt werden können. Das "Reasoning" in der Inferenz sind Evaluierungsfeedbackloops, die das Modell für die Problemlösung durchläuft.

OpenAI hat seit der initialen GPT-4-API ein zugegeben für den Rest der Menschheit recht lustiges Problem: Andere Modellprovider können die API ausnutzen, um ihre eigenen Modelle damit zum Teil zu trainieren. Synthetische Daten sind ein sehr großes Thema geworden. (Man beachte dem gegenüber den himmelschreienden Bullshit, den Laienkommentatoren 2024 über die Wirkung von KI-generierten Daten auf LLMs von sich gaben.)

Deepseek sind nicht die ersten, denen das vorgeworfen wird.

Wie dem auch sei. OpenAI gibt die Reasoning-Token nicht aus, weil sie unter anderem erstklassige synthetische Trainingsdaten darstellen würden. Im Gegensatz zu o1 und o3 gibt R1 auch die Reasoning-Token aus, die das Sprachmodell zur Evaluierung und Erstellung der endgültigen Antwort erstellen muss.

Das hat zwei signifikante Auswirkungen:

- Interface: User erhalten erstmals mehr Einblick in die interne "Arbeit" des KI-Modells. Sie können sehen, wie das Modell Aspekte bewertet, verwirft, falsch abbiegt, sich korrigiert (oder nicht). Das ist eine Transparenz, die nicht zwingend für private User interessant ist. Aber es ist enorm wichtig für Enterprise-Einsätze. Sichtbare Reasoning-Tokens sind das zweitwichtigste Interface-Thema in KI 2025. (Das wichtigste Interface-Thema sind Agents wie OpenAIs Operator.)

- Modelltraining: Die Reasoning-Tokens im Output machen R1 und seine mit Sicherheit kommenden Nachfolger zur sehr offensichtlichen Grundlage für die Erstellung weiterer Modelle. R1 hat damit Llama vorerst als zu bevorzugendes Basismodell abgelöst. (Eine Folge davon: Meta wird mit Hochdruck an Reasoning-Llamas arbeiten, die ebenfalls Reasoning-Tokens ausgeben werden.)

Zweiter entscheidender Aspekt: R1 kommt aus China, Huawei, Ökosysteme

Im Rahmen meiner Recherche für die FAZ bin ich auf einen wichtigen Fakt gestoßen:

Die offizielle, vom Unternehmen in China gehostete Version von Deepseek etwa läuft sehr wahrscheinlich auf 910C-Chips von Huawei.

Hier kommt bereits ein Ökosystem-Vorteil von China zum Tragen. Mit der direkten Unterstützung von Huawei-Chips stärkt R1 den durch die US-Restriktionen geschwächten Chipbereich von Huawei. Hier sieht man auch einen Teil der Erklärung, warum High-Flyer die Modelle quasi verschenkt. Peking dürfte sehr erfreut sein, wenn ein populäres R1 dafür sorgt, dass Huawei in Datencentern weltweit Marktanteile gewinnt.

Laut Huawei ist der Ascend 910C von der Leistung her mit Nvidias H100 vergleichbar. (Toms Hardware)

Das hat weitaus mehr Implikationen als die Frage nach dem Training, mit dem sich alle diese Woche beschäftigt haben.

Das Training hat höchstwahrscheinlich trotz Exportverbot auf Nvidia-Chips stattgefunden, und es dürfte ebenso stark von GPT-4 profitiert haben.

Aber die eigentliche geopolitische Musik liegt in der Inferenz, der Nutzung der KI.

Hier sehen wir einen Grund, warum es in Peking wohlwollend gesehen werden dürfte, dass Deepseek sein Modell an die Welt "verschenkt":

Ein weltweit populäres chinesisches KI-Modell, das "kostenfrei" im eigenen Datencenter eingesetzt werden kann, wird zum Komplementärgut für die nicht nur geopolitisch sehr wichtige chinesische Chip-Industrie.

Hier liegt eine der vielen Gefahren, wenn China eine globale KI-Macht wird:

Hochperformante KI-Modelle aus China können die chinesische Chip-Industrie pushen.

Jeder chinesische Modell-Anbieter hat ein Interesse daran, chinesische GPUs direkt zu unterstützen und hierfür zu optimieren:

- Sowohl wirtschaftlich, weil die USA einen Exportbann nach China für die besten GPUs auferlegt hat.

- Als auch politisch. Peking wird das explizit wie implizit von jedem Anbieter erwarten.

Heimlich über Singapur und Co. importierte Nvidia-Chips lassen sich für das Training nutzen. (Singapur "importiert" mehr GPUs als das dortige Stromnetz verkraften könnte.) Aber das ist keine nachhaltige Basis für die Inferenz, die weitaus mehr Rechenleistung verbraucht.

Das ist auch ein Missverständnis überall, in den Medien, in den Netzwerken und an der Wall Street: Der Datencenter-Aufbau findet in erster Linie für die Inferenz statt und erst in zweiter Linie für das Training.

Oder anders: Training sind Vorabkosten, Inferenz ist die Nutzung der Investition. Dort liegt die Rechenleistung, dort liegt der Umsatz, dort liegt das Geschäft.

Inferenz ist außerdem preiselastisch. Intelligenz für ein Zehntel der Kosten sorgt nicht dafür, dass nur ein Zehntel der Kapazitäten genutzt werden. Es sorgt dafür, dass sehr viel mehr künstliche Intelligenz überall zum Einsatz kommen wird.

Als ich Anfang des Jahres bereits ausführlich für die FAZ über Deepseek schrieb, hatte die FAZ-Redakteurin Nina Müller die Idee für das Framing von Deepseek als das "Temu der KI-Welt". (Siehe hierzu auch mein Deep Dive zu Temu.)

Einige Analogien sind offensichtlich:

- Aus China

- Spottbillig

- Potenzial für trojanisches Pferd

- Herausforderung für westliche Konkurrenten

Einen nicht so offensichtlichen Punkt, den ich bei Temu und Shein regelmäßig gemacht habe, trifft auch auf Deepseek zu:

In der aufgeschreckten “Huch-China-mischt-jetzt-auch-mit”-Debatte wird in erster Linie auf die Heimatmärkte, also USA und Europa, geschaut.

Die chinesischen Billig-Marktplätze Temu und Shein machen allerdings gleichzeitig und vor allem die internationalen Märkte zu. Der globale Süden, Entwicklungsländer, diese Märkte haben Haushalte mit geringerem verfügbaren Einkommen (und kleinere Staatshaushalte). Sie sind noch einmal stärker empfänglich für Anbieter, die ihnen die "gleichen" Produkte günstiger verkaufen.

Deshalb bedeuten Temu und Shein als allgemeiner Handelstrend etwa, dass sich das gesamte Internationalisierungspotenzial des hiesigen Handels verkleinert.

Wir können etwas Ähnliches in KI beobachten. R1 ist nicht der Anfang, aber der bis dato sichtbarste Punkt an dieser Stelle.

R1 ist billiger in der Inferenz, also der Nutzung, kommt aber auf vergleichbare Ergebnisse wie OpenAIs O1.

Das ist gut für uns in Europa, aber sehr viel wichtiger für zum Beispiel Nigeria.

Welche Optionen haben Entwicklungsländer, die KI-Projekte in die Bildung oder Wirtschaft bringen wollen?

Teure proprietäre US-Modelle auf Nvidia. Oder nun bald: Günstigere "offene" chinesische Modelle, die auf chinesischen Chips in lokalen Datencentern laufen.

Der Erfolg von Temu und Shein hat dazu geführt, dass die chinesische Regierung mit Silk Road E-Commerce (Exciting Commerce) erkannt hat, wo sie einen Handelsvorsprung für sich nutzen kann: Online.

Der Aufruhr von R1, dem sicher bald R2 und R3 folgen werden, könnte einen ähnlichen Effekt in Peking haben.

China muss seine eigene Chip-Industrie mit ihren notwendigerweise eigenen Lieferketten international etablieren. Die USA haben China abgeschnitten, das schmerzt die dortige Industrie. Aber sie holt auf.

KI als Komplementärgut zu den Chips, auf denen die Inferenz läuft, kann das enorm beschleunigen. Silk Road KI.

Wenn China sich innerhalb des nächsten Jahrzehnts auf diesen Weg unabhängig von der internationalen Halbleiterindustrie machen konnte, dann steht dem Einmarsch in Taiwan quasi nichts mehr im Wege.

Es sind globale Themen. Wirtschaftlich wie geopolitisch.

R1 und Europa

Bittersüße Situation

Für uns in Europa ist R1 eine bittersüße Lektion.

Einerseits ist die Dominanz der USA in KI damit endgültig gebrochen. Ab sofort ist es mindestens ein Rennen zweier Mächte.

Allerdings: Die EU spielt keine Rolle. Schon wieder.

Wir haben einzig Mistral aus Paris, das halbwegs global mitspielen kann.

Lichtblicke:

- Deepseek zeigte mit R1, dass man auch mit geringeren Mitteln mithalten kann. Selbst wenn man bei der geringen Höhe der Mittel etwas geflunkert haben sollte.

- R1 ist selbst nicht nur günstig im Betrieb, sondern dank der Reasoning-Tokens eine hervorragende Grundlage für die Destillierung eigener Modelle.

- Damit bekommt auch die europäische Wirtschaft eine Grundlage, hochspezialisierte eigene Modelle zu bauen. Und zwar ohne unwirtschaftlich hohe Vorabkosten. (Hinweis: Das ist natürlich bereits auch ohne R1 möglich. R1 erlaubt nun aber eine weitaus höhere Qualität bei gleichbleibenden beziehungsweise gesunkenen Kosten.)

Die europäische Datenpipeline

Neben dem RL-Fokus sticht bei Deepseeks Ansatz auch heraus, dass sie wie so viele Anbieter "offener" Modelle alles freilegen außer den Trainingsdaten.

Die Trainingsdaten sind enorm wichtig.

Ich hatte hier im Briefing bereits einmal geschrieben, dass wir in Europa einzigartige Wissensschätze in unseren Archiven haben, die wir auch für KI-Training nutzen können.

Diese sollten in eine europäische Datenpipeline fließen, welche die Daten entsprechend aufbereitet und gewichtet. Zugang zur Datenpipeline bekommen nur öffentliche und private Modellanbieter aus der EU. (Irrelevant ist, ob, wie bei Mistral, Nicht-EU-Unternehmen Investoren in die EU-Organisationen sind. Entscheidend ist es, in der EU Strukturen aufzubauen.)

Aleph Alpha

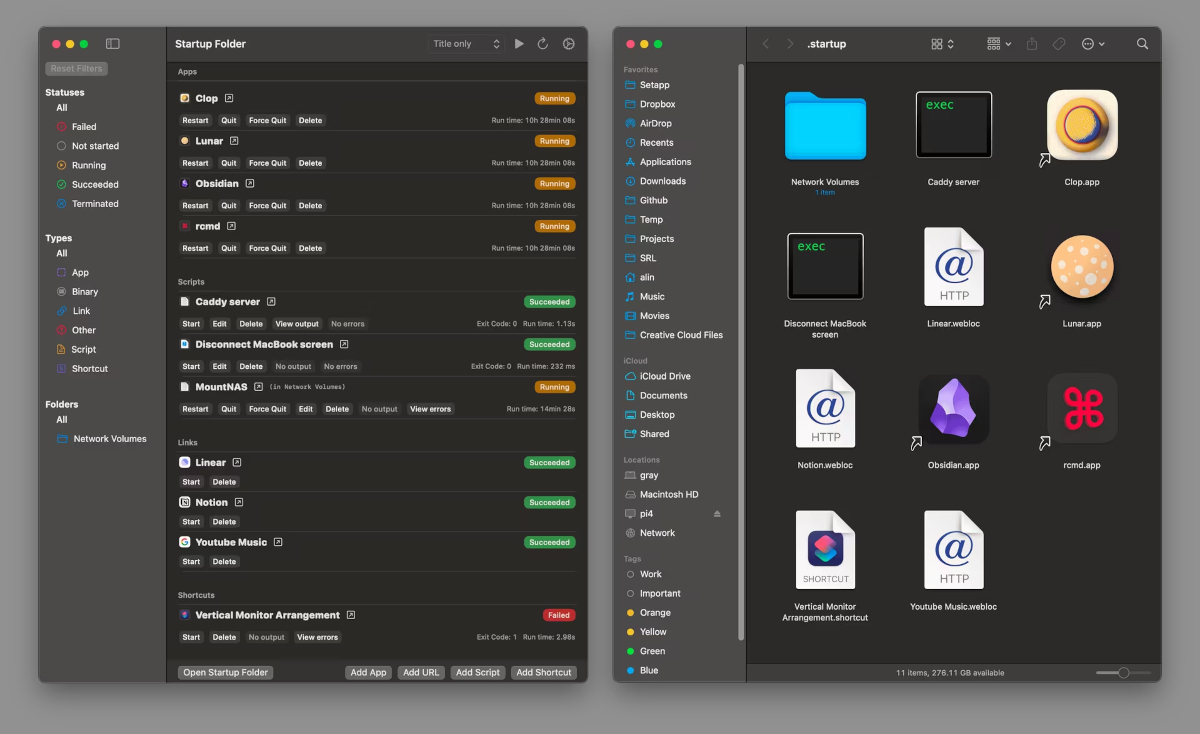

R1 ist eine gute Nachricht für Aleph Alpha und ähnliche Unternehmen.

Einige Zeit vor dem Pivot des Unternehmens hatte ich im Februar 2024 im Briefing bereits geschrieben, dass Aleph Alpha die eigene Modellentwicklung zugunsten einer Implementationsstrategie aufgeben sollte. Briefing 186:

Das Szenario:Aleph Alpha wird ein Integrationspartner und Datencenterbetreiber, quasi ein spezialisierter Cloud-Computing-Anbieter, für KI-Implementationen bei datensensitiven Einsätzen in der deutschen/europäischen WirtschaftHierfür werden neben den Luminous-Modellen auch Modelle wie Mixtral integriert.Mittelfristig würde das heißen, dass die Bedeutung der eigenen Modelle schrittweise eher zurückgeht.Der Vorteil von Aleph Alpha hier wäre natürlich, dass die Modelle sich kombinieren lassen.Daraus könnte sich sogar eine Spezialisierung auf Modellebene als USP herausschälen: Die Modelle von Aleph Alpha sollten auf die Customizationseite hin optimiert werden, also Übersetzer zwischen den Unternehmensdaten und den die eigentliche Arbeit übernehmenden Modelle.

R1 zeigt, wie weit weg Aleph Alpha bei den eigenen schlechten Modellen davon war, wo sich die KI-Welt hinentwickelt. Gleichzeitig zeigt R1, wie viele Optionen sich bei einem modellagnostischen Ansatz eröffnen können.

R1 ist hervorragend geeignet, angepasst oder im Verbund, etwa mit einem Mixtral-Modell, von Aleph Alpha für deutsche Compliance-schwere Tätigkeiten implementiert zu werden.

Das gilt umso mehr für jedes anpassbare, vom Kunden selbst betreibare Modell, das nach R1 kommen wird.

Zensur und subtile Beeinflussung sind zwar Themen, die man bei chinesischen Modellen immer mitdenken sollte. Es ist aber noch unklar, wie stark oder schwach sich das auf selbstgehostete, angepasste Modelle oder gar auf destillierte Modelle auswirken wird. (Siehe etwa R1 auf Perplexity, gehostet von Perplexity in den USA.)

AI Act

Deepseek senkt geradezu grotesk enorm die Schwelle für die nötige Rechenpower für state of the art KI, die unter anderem vom AI Act für Unterscheidungen genommen wurde. Bereits das zweitkleinste R1-Modell läuft lokal auf Laptops. Nicht gut, aber läuft.

Wo werden wir Ende des Jahres stehen?

Was genau lässt sich mit dem AI Act aufhalten, wenn Modelle auf GPT-4 oder O1-Level lokal laufen können?

Der AI Act geht unter anderem implizit davon aus, dass jede KI-Entwicklung außerhalb der EU etwa die europäische Öffentlichkeit nicht treffen kann mit KI-basierten Beeinflussungen. Was genau verhindert der AI Act, was China mit seiner hocheffizienten KI auch im europäischen Internet anrichten kann?

Der AI Act als europäische Regulierung ist mit seinem Ansatz und Ziel leider Unsinn.

So etwas würde nur auf globaler Ebene, etwa in der UN, funktionieren. Alles andere ist illusorisch im Sinne von "wenn ich meine Hände hinter dem Rücken verschränke und sage, dass alle das machen sollen, verhindere ich, dass du mich schlagen kannst".

✴️ Mehr Wissenswertes

**Perlentaucher wird 25.**Herzlichen Glückwunsch! IN EIGENER SACHE: Editorial: 25 Jahre Perlentaucher :

Wir konzentrieren uns aber auf unsere Kernkompetenz: Seit 25 Jahren lesen die PerlentaucherInnen getreulich die deutschen Feuilletons und verfassen zu so gut wie allen Buchkritiken resümierende Notizen. Der Perlentaucher ist ein Abbild der literarischen Öffentlichkeit seit 25 Jahren. Darum haben wir an einige der bekanntesten Literaturkritiker und -kritikerinnen die Frage gestellt: "Welches waren für Sie die fünf prägendsten Bücher der deutschsprachigen Literatur seit 2000?"

Tiktok Shop kommt. Jochen Krisch in TikTok Commerce könnte in Q2 in Deutschland loslegen :

So wie es aussieht, könnte TikTok Shop im 2. Quartal in Deutschland starten. Für den Standort München sind jetzt wieder etliche Stellen ausgeschrieben. An

Nachrichten auf TikTok. OMR über Newsfluencer Fabian Grischkat: "Die Nutzung sozialer Netzwerke wird politischer" :

Kann man in unter 100 Sekunden die Welt erklären? Mit Sicherheit nicht, aber man kann es immer wieder versuchen – so wie Fabian Grischkat auf seinem Tiktok-Kanal. Mehr als 100.000 Menschen folgen ihm dort, auf Instagram sind es rund 160.000, denen die Kombi aus "Politik und Spökes", wie Grischkat seine Inhalte beschreibt, offenbar gefällt. In seinen Beiträgen versucht der 23-Jährige, komplexe Sachverhalte runterzubrechen, Behauptungen Fakten gegenüberzustellen und dabei gleichzeitig zu unterhalten

Das wird bei fast jedem Video mehr Reichweite bedeuten als klassische Massenmedien in Deutschland mit Nachrichten erreichen. Oder sollte ich schreiben "Massen"medien?

~