DeepSeek научилась лучше распознавать изображения: что изменилось

Теперь сервис не просто анализирует изображения, но и понимает их значение еще глубже, точнее и быстрее. Рассказываем подробности. Разработчики представили обновленную версию модели DeepSeek-VL2, которая демонстрирует серьезный скачок в распознавании изображений и их анализе. Улучшения коснулись сразу нескольких ключевых направлений: работы с текстом на картинках, интерпретации сложных визуальных данных и более точного соотнесения изображений с текстовым контекстом. DeepSeek-VL2 создана на основе концепции Mixture-of-Experts (MoE) — это архитектура, в которой несколько моделей работают одновременно, выбирая наиболее подходящий алгоритм для конкретной задачи. В новой версии разработчики внедрили три варианта модели: DeepSeek-VL2-Tiny (1 млрд активированных параметров), DeepSeek-VL2-Small (2,8 млрд) и DeepSeek-VL2 (4,5 млрд). Это позволило значительно повысить точность анализа при минимальном увеличении вычислительных затрат. Оптическое распознавание текста и его улучшения Одно из самых заметных улучшений в DeepSeek-VL2 связано с оптическим распознаванием символов (OCR). Теперь модель точнее выделяет текст на изображениях, даже если он наложен на сложный фон, частично скрыт или написан нестандартным шрифтом. Благодаря этому DeepSeek-VL2 успешно анализирует документы, таблицы и диаграммы, извлекая из них нужную информацию без искажений.

Теперь сервис не просто анализирует изображения, но и понимает их значение еще глубже, точнее и быстрее. Рассказываем подробности.

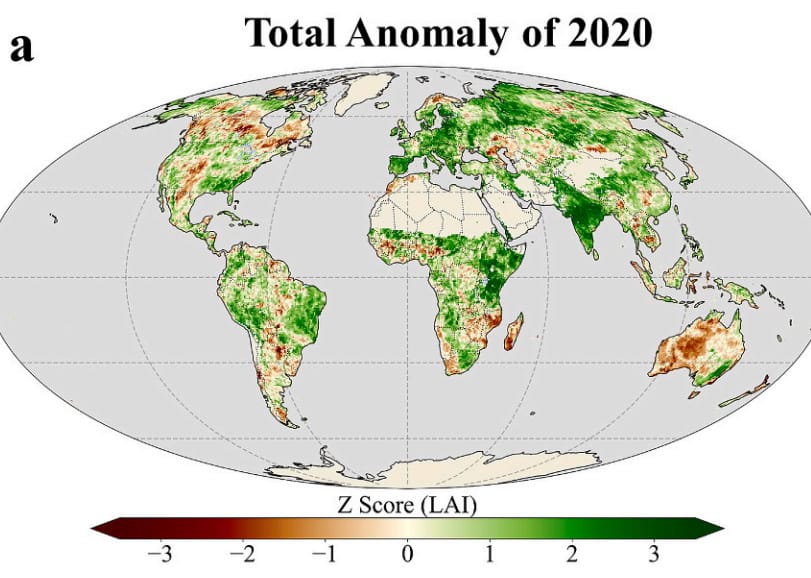

Разработчики представили обновленную версию модели DeepSeek-VL2, которая демонстрирует серьезный скачок в распознавании изображений и их анализе. Улучшения коснулись сразу нескольких ключевых направлений: работы с текстом на картинках, интерпретации сложных визуальных данных и более точного соотнесения изображений с текстовым контекстом.

DeepSeek-VL2 создана на основе концепции Mixture-of-Experts (MoE) — это архитектура, в которой несколько моделей работают одновременно, выбирая наиболее подходящий алгоритм для конкретной задачи. В новой версии разработчики внедрили три варианта модели: DeepSeek-VL2-Tiny (1 млрд активированных параметров), DeepSeek-VL2-Small (2,8 млрд) и DeepSeek-VL2 (4,5 млрд). Это позволило значительно повысить точность анализа при минимальном увеличении вычислительных затрат.

Оптическое распознавание текста и его улучшения

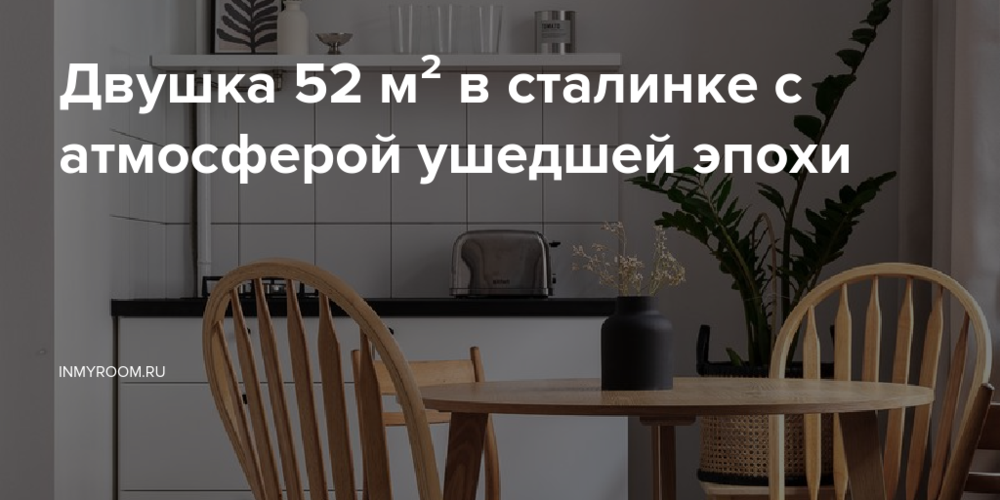

Одно из самых заметных улучшений в DeepSeek-VL2 связано с оптическим распознаванием символов (OCR). Теперь модель точнее выделяет текст на изображениях, даже если он наложен на сложный фон, частично скрыт или написан нестандартным шрифтом. Благодаря этому DeepSeek-VL2 успешно анализирует документы, таблицы и диаграммы, извлекая из них нужную информацию без искажений.